Yaffle: ロジカルな作編曲&プロデュース、偶発性によるサウンドデザイン

藤井風やiri、小袋成彬への楽曲プロデュースで高い人気を誇る音楽プロデューサーYaffle氏。幼少期のピアノ経験を皮切りに、高校時代は吹奏楽部と軽音部を兼部、その後に進学した音楽大学では前衛音楽を学ぶなど、クラシックからビッグバンド・ジャズ、ロックと幅広い音楽に触れてきた同氏は、ジャンルに囚われない色鮮やかな楽曲を数多くリリースしてきた。

2023年2月28日に配信された“Ableton Presents: In Session with Yaffle”では、ポケットモンスター25周年を記念し、世界のトップ・アーティストが集ったミュージック・プログラム『P25 Music』に日本人として唯一参加した際の楽曲『Reconnect』のメイキングが1時間以上にわたって語られた。今回はこのアーカイブを振り返るとともに、Yaffle氏のコンセプトメイキングや楽曲制作に対する考え方、そしてAbleton Liveを使い続ける理由を紐解いていく。

クラシック、ポップス、ジャズ、ロック――好きなものから貪欲に知識を吸収した学生時代

作編曲からプロデュースまで幅広く制作に携わるYaffle氏ですが、音楽を作り始めたきっかけや、これまでの歩みを教えてください。

小さい頃からピアノを習っていて、そこで譜面の読み書きを覚えました。その後ポップスにも興味を持つようになり、コード進行や楽曲構成を学びながら、少しずつ音楽を作る方向に意識が向いてきました。

直接的なきっかけになったのは『S.W.A.T.』(2003年,オリジナル・フィルム作)の劇伴に感銘を受けたことで、「自分でもやってみよう」と思って最初はテキストベースの打ち込みソフト(Muse)で遊んでいました。その後もMIDIを打ち込んでは実家の電子ピアノで鳴らすような遊びをしていて、恐らくこのあたりが音楽制作的なことの原体験だと思います。

最初はプレイヤーとして、その後は趣味で打ち込みを始めたと。編曲に関するスキルはどのように養ったのでしょうか?

高校時代は吹奏楽部でファゴットを吹いていたのですが、そこでは皆がやりたい楽曲のアレンジ譜面を書いていたんです。吹奏楽部は野球部の応援に駆り出されることもあって、選手が希望する楽曲によっては「譜面がない!」ということもよくあったので、私が全員分の譜面を用意していました。

こうした経験もあって、卒業後は国立音楽大学の作曲科に進みました。隣の電子音楽科がMax/MSPなどを使ってインスタレーション作品などを作っているなか、私はひたすら紙とペンで勉強をしていましたね。

同時期にジャズにも傾倒して、ジャズ系のインカレサークルにも所属していました。前衛音楽をやっていた自分も実験的なビッグバンド・ジャズの譜面を書いてみたり、即興音楽に興じてみたりする日々を過ごしました。

もともとエレクトロニック・ミュージックの文脈ではなく、生楽器の演奏や作編曲の専門家としてのバックボーンを持っているわけですね。いつ頃から今のようなスタイルを確立したのでしょうか。

僕はガレージロック・リバイバルの直撃世代で、音大に進学する前から軽音楽部にも顔を出していたんです。そこではMacを使って、初めて買ったDAWをレコーダー代わりに回していました。そういった背景もあって、卒業後は自宅を改装したガレージスタジオで、録音の仕事を始めたんです。その当時はセッションプレイヤーと一緒に仕事をすることが多くて、サックスプレイヤーのMELRAWさんやKing Gnuの新井くんなどのスタジオに出入りしていました。

その頃に小袋成彬くんたちと出会って、Tokyo Recordings(現・TOKA)という会社を作りました。CM音楽などを職人的に作りながら、自分たちでもレーベルとして発信していこうという流れで、アーティストを発掘して売り出していくという仕事を始めました。ここまでいろいろありましたが、再び高校生の頃に好きだったポップスやロックに回帰したわけです。これがプロデュース業の始まりでした。

「打ち込みが楽しいと思えた」Ableton Liveとの出会い

ここまでのお話では生楽器中心のキャリアだと感じましたが、いつ頃から打ち込みを駆使した音楽制作を行うようになったのでしょうか?

エイフェックス・ツインなどワープ系(ワープ・レコーズの作品群)は好んで聴いていましたが、20代前半までは生楽器中心のスタイルでした。ただ、2000年代後半に始まったEDMブームが2013年頃には次の段階に入って、そこから徐々にテンポが105くらいとか、少しずつ落ち着いてきて。トランスの流れが強かった時期はイマイチだったんですが、縦ノリというよりChill要素が色濃く入ってきて、そういった楽曲が自分のバックボーンとして持っていたジャズの文化とも噛み合うようになって……同時期、ポップスのフィールドでもエレクトロニック・ミュージックとの融合が盛んになっていたこともあり、いよいよ自分でも打ち込みを使った音楽を制作しようと考えました。そこで出会ったのがAbleton Liveなんです。

Ableton Liveを導入した時期や経緯を教えてください。

Jack Uの動画で使っているのを見て、Live 9 Suiteを購入したのが最初だったと思います。それまでは打ち込み自体に苦手意識があったのですが、Liveはクリップビューでのエディットがとても直感的で、いつの間にかMIDIプログラムそのものにハマってしまって。ちなみに、最初に買ったパックは「Omar Hakim Drums」でしたね。

制作環境を移行してから最初にリリースした楽曲を教えてください。

2016年にリリースしたiriの『rhythm』です。この時はデモで作ったプロジェクトをもとに完パケまで持っていったので、しっかりLiveで作りきった最初の楽曲になります。

これまでは「ミュージシャンを呼んでレコーディングをする」という方向で音楽を作っていたため、打ち込みはあくまで生楽器の代替品だったんです。Liveに出会ってから、初めて打ち込みの面白さに気付きました。

『Yaffle - Reconnect(feat. Daichi Yamamoto & AAAMYYY)』制作の裏側と“コンセプト”

ここからは、先日の「In Session with Yaffle」で紹介されたメイキングについて、改めて質問させてください。『ポケットモンスター』(以下、ポケモン)シリーズの25周年を記念した『P25 Music』に収録された本楽曲ですが、まずは制作全体の流れを教えてください。

最初の打ち合わせが2021年7月下旬で、リリースが同年11月だったので、非常にタイトなスケジュールでした。海外でのマスタリングに間に合わせるため、翌週ビートを作って、さらにその翌週トップラインのやり取りをして、その翌週にDaichi YamamotoとAAAMYYYのレコーディングをして、結局3週間で全てを作りきりました。

打ち合わせのとき、ポケモンのコンセプトについて教えていただいたんです。世界中みんなが身近に感じられるような無国籍感があり、現実のような世界観にも関わらず特定の土地の固有名詞は出さないことや、近所にポケモンがいるかも知れないと思ってもらえるようなリアリティの話など、さまざまなフィロソフィーを語ってもらいました。

作品のコンセプトから楽曲のコンセプトに落とし込む際のプロセスを教えてください。

ポケモンには可愛い系だけではない、いろいろな種類のキャラクターが登場します。今回も、あえてキレイにキャラクターを見せるよりは、現実と地続きである世界観の中にポケモンが生きている感覚を作ろうと考えました。Dustyというか、キレイ過ぎない感覚をサウンドに落とし込むために、あえてオングリッドのビートではなく、ルーズなリズムを作っています。

例えば、808(TR-808、通称ヤオヤ)のサウンドをオングリッドで並べればスッキリしたビートになりますが、今回はあえて生ドラム系のサンプルやアナログコンプで激しく潰したようなルームマイクの音像を積極的に使っていました。また、サウンドに汚しを入れただけでは大人っぽい雰囲気が強くなってしまいますので、ポケモンとのつながりを作るために当時(ポケットモンスター赤・緑)の音楽や効果音をサンプリングして使用しました。

これに加えて、自分にとっては東京がホームなので、東京というゴチャゴチャした街並みのストリートを想起するようなカオス感も入れ込んでいます。洗練されすぎていない、東京の街並みの延長、カオス感。こういったものをテーマに制作を進めました。

実際のビート制作について教えてください。配信中、「ビートはロジカルに作る」という話題もありましたが、この作品ではどのようにグルーヴを演出しているのでしょうか。

ロジカルに行くと「オングリッドから何msecズレた場合、どういう効果があるか」といった研究もありますが、逆にセンスでマスターしている人もたくさんいます。ドランクビートなどは最たるものですね。僕はリズム単体で考えることはせず、基本的に他のシーケンス次第で「2拍4拍をパキッとさせるのか」「スネアを外すかどうか」「キックの前後」などを決めています。全部オンでいって、ハイハットだけ揺らすこともあります。

今回はポケモン原作のオープニング楽曲をサンプリングした素材をベースに組み立てました。オングリッドで刻むサンプルが手前にあり、ルーズなビートが奥行きとなる対比を作っています。スネアはオングリッドで、キック側をズラしています。グリッドから離れるほどカオス感は増しますが、正気を保つトラック(オングリッドのトラック)がないとカオスや汚れが引き立ちません。また、アルペジエーターのパラメータにLFOをアサインして揺らすなど、リズムトラック以外にも偶発性を持つトラックを数多く採用しています。

LFOでArpeggiatorのパラメータに揺らぎを与えている。

ポケモンのオープニング楽曲を用いたリフも印象的でした。

ゲームボーイは音色が矩形波のみだったので、音程だけで展開を作るために転調が多いんです。和音数も少ないので、譜面的な工夫やアプローチが面白いんですね。

これは個人的な感覚ですが、楽曲の良し悪しとは別に、自分の中に「格」という判断基準があって、例えばコードが複雑に進行していくよりも、Fメジャー1発で格好いい曲を書けたほうが「格」が高いと思うんです。また、自分はピアノを弾きますが、ギターは弾けません。ピアノもギターも、コードもメロディラインも両方を担える楽器ではありますが、ギターの方がモノフォニー要素が強いために「格」が高いと思っているんです。

たしかに、ギターの場合はビブラートやチョーキング、ハンマリングなど、単音で奏でる際の選択肢が多いですね。ここでいう「格」というのは、格式とも言い換えられるのでしょうか。

楽曲自体の評価や楽器の良し悪しではなく、あくまで自分の中での評価軸にはなりますが、すごく「格が高い」と感じる音楽はコードがシンプルだったり、コードストロークよりもモノフォニーの集合体として和音が形成されていたり、Abletonが出している「One Thing: Sasha Perera」動画のように、あえてコードを分解して考えたりするような構築が好きなんですよ。中域を排除するほうがボーカルが映えるので、歌モノの場合はあえてコードをなくすこともあります。

こう考えると、ポケモンのお題はすごく「格」が高いんですよね。メインテーマはコード1発なので、自分もなるべくコードをステイして作るようにしました。プリコーラスのところはコードが進行してしまっているので、「負けたな」と思いましたね。

思考プロセスを邪魔しないスピード感、偶発性によるサウンドデザイン

Liveで楽曲制作を行う際、よく使うティップスがあれば教えてください。

Liveの良さはティップス的な要素の多さではなく、制作のワークフローが優れている点が一番のメリットだと思います。僕の目線では、Liveは多機能DAWにならないように意識されていると感じています。やりたいことありきで、それに対して最速でアプローチできるような階層の浅さ、直感性、この辺りが意図的に設計されているのではないかと。

他DAWだと、多機能性だったり、ショートカットの多さだったり、あるいは有名プラグインとのインテグレートなどをもって巨大化したワークステーションとして成り立たせるものも少なくないと思います。でも、Liveは逆で、「こういうことがやりたい」と思ったらすぐに目的までアクセスできる階層の浅さが魅力です。字面通りに受け止めたら機能は多いほうが嬉しいと思いますが、でもフラットデザインだったりワンウィンドウで完結する仕様だったり、いざ使うと目的へのアプローチの速さがすごく良いな、と思います。

たしかに、Liveは機能群がシンプルにまとまっていたり、深い階層まで降りる設定が少ないように感じます。

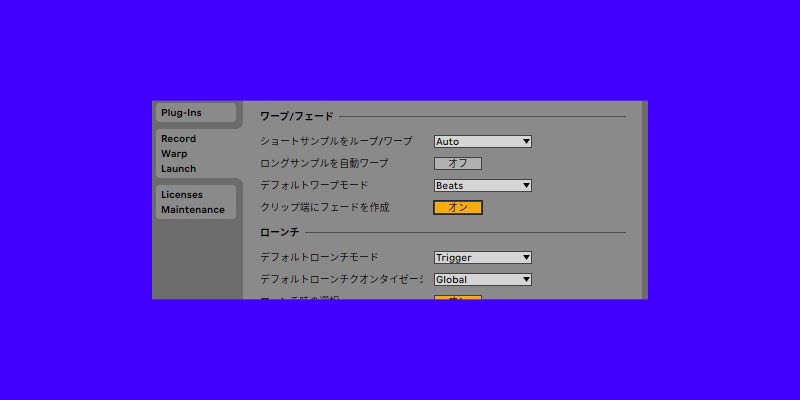

機能としては、例えばサンプルの自動クロスフェードなどが気に入っています。リズム構築の際スネアなど1パーツだけを急に差し替えることも多いですが、こうした場合もリージョンの前後をケアしなくて良くなります。

環境設定の [クリップ端にフェードを作成]がオンに設定されている。

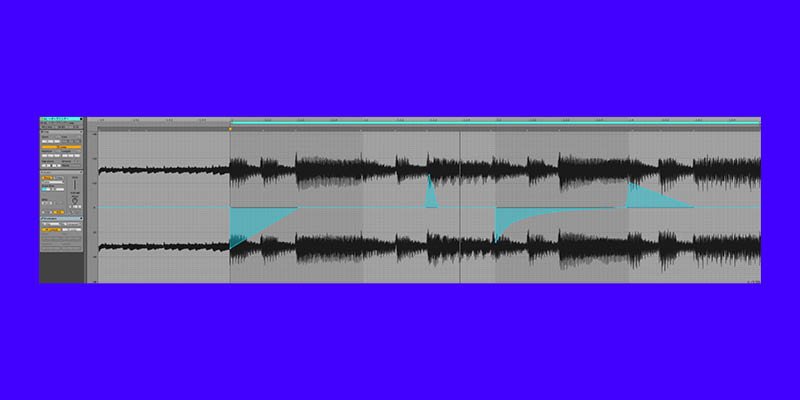

また、エンベロープパネルでの編集作業において、ピッチやボリュームなどのパラメータをオーディオ/MIDIファイル自体に書き込めるのも直感的で素晴らしいと思います。オーディオとMIDIの垣根がないのもLiveの面白いところで、例えばCommand+Fで検索をすると、プラグインもサンプルも全部同じ画面に出てくるというのが発想として面白いんですよね。

サンプルエディタ内で、オーディオファイルに直接パラメータを書き込んでいる。

シンプルかつ目的に一直線でアプローチできる部分とは別に、Max for Liveによる複雑な拡張もLiveの面白い部分だと思います。デバイスによる拡張について、普段から活用されていますか?

DAWの補助機能となるユーティリティ系は普段から使っています。例えば、CC64(ホールド1、ダンパーペダル)の値を0にする「CC64Killer」(Ableton認定トレーナーの岡本隆司 氏が作成)や、クリップゲイン系のデバイスをよく使います。

ほかにも、例えば「Inspired by Nature」や「Bouncing Ball」などのデバイスは汚し系のエフェクトとして使うことがあります。イントロや間奏、あるいはブレイクで思いきりグチャッとさせたサウンドデザインを行う際はMaxや複雑なLFOが役に立つことが多いですね。ただ、Max for Liveに限らず、細かなサウンドデザインやティップスにこだわってプロセスを正当化するような、手段と目的の逆転には注意が必要だと思います。あくまで楽曲としてアウトプットすることが正義です。

ありがとうございました。インタビューの総括として、Yaffle氏がLiveを使い続ける理由を教えてください。

道具の影響を受けて楽曲の方向性が決まるということは往々にしてあって、これはDAWも同じだと思います。たとえば、クラシック音楽の歴史において、もともと「楽譜」は記録メディアとして発明されたものでした。ですが、その後は記録メディアのほうに影響を受けて、楽譜で書くからこそ想像できるような難解なオーケストレーションが生まれることもありました。楽譜を永遠に書き続けても、トラップ・ミュージックは生まれなかったでしょう。楽譜の上で音楽を作るエキスパートは、そのエキスパート性によってむしろ制約を受けているとも言えます。

Max for Liveによる拡張もありますが、Live自体サウンドデザインが得意で、どこまでも凝ったことができるDAWです。ともするとカオスが臨界点を越えてしまうこともありますが、たまに自分が理解できない偶発的なサウンドが出てくるのが面白くて、同じポップスを作る場合もLiveならではのサウンドになるような感覚があります。自分の脳内にある完成形を普通にアウトプットするだけでなく、いかに着地点から上手く反れるか。思い描く正解とツールによる個性、あるいはエラーによる手触りの変化など、さまざまな理由で「作っている自分自身を驚かせてくれる」からこそLiveを使い続けているのかもしれません。

文・インタビュー:神山 大輝