tofubeats: ライブ活動における思想とAbleton Liveコミュニティに対する“熱い信頼”

若くして才能を発揮し、高校時代から仕事としてリミックスなどの音楽活動を続ける音楽プロデューサー/DJのtofubeats氏。楽曲制作だけでなく精力的なライブ活動を行う同氏は現在Ableton Liveの機能を駆使したライブセッティングを用いており、2023年8月に公開された“Ableton Presents: In Session with tofubeats”では「プロジェクトの内側」が余すところなく披露された。

今回のインタビューでは、より詳しいプロジェクトの内容について触れるとともに、ライブ全体に通底する思想やDJプレイの考え方などtofubeats氏が持つ“ライブ術”について深掘りする。

HIPHOPからテクノミュージックへ、そしてLiveに出会うまで

――まずは音楽的なバックボーンについて教えてください。

小学生の頃からよくJ-POPを聴いていたので、漠然と「中学生に上がったらバンドをやりたい」と考えていました。中学に上がってすぐエレキベースを買ってもらったんですが、ベースは1人で弾いてもあまり楽しくなくて……すぐに熱が冷めて、友人に譲ってしまいました。

いまも竿物(ギターやベースなどのネックを持つ弦楽器)はまったくフィットしないのですが、この頃から感覚は変わっていないんですよね。

――現在のようなトラックを好んで聴くようになったのはいつ頃なのでしょうか?

楽器演奏を諦めたあと、友人から日本語ラップやJ-HIPHOPというジャンルを教えてもらったんです。ただ、中学生のお小遣いでは満足にCDが買えなかったので、音楽を聴くのはもっぱらインターネットのアマチュア投稿サイトでした。

その当時は音楽投稿サイトや2ちゃんねる(現・5ちゃんねる)での交流が盛んで、楽曲投稿だけでなく制作に関する情報も数多くやり取りされていました。自分もそこに混ざりたいという気持ちが強くなって、中学2年生の頃にKORG/ELECTRIBEを購入してもらって楽曲制作を始めました。

2010年のAbletonをライブで使い始めたリハーサル時の写真。

――当時はデスクトップタイプのステップシーケンサーが流行っていましたね。ELECTRIBEは、ミニマル的なループミュージックを作るのにはすごく向いている名機でした。

音楽理論や楽器の知識がない状態でも気軽にループが作れるのはすごく楽しかったですね。私の場合はWindows MEマシンのサウンドカードに直接ステレオ音源を録音して掲示板に投稿して、すぐに叩かれていましたが、当時まだ中学生だったこともあってオフ会でもすごく気を遣ってもらって……。そこでいろいろと教わりながら、高校生に上がってからはAKAI/MPC-1000で本格的な制作を始めて、次第にリミックス音源の制作などの仕事を受けるようになりました。

――この頃はまだLiveに出会っていないんですね。PCでの制作を始めたきっかけや理由はありますか?

高校3年生の頃に「WIRE」というテクノミュージックの大型イベントに出演させていただくことになったんです。その頃にテクノをたくさん聴いて勉強して、「四つ打ちも面白いじゃん!」と思い始めて。時代的にもDTMが流行っていたのと、友人のimoutoidがAbleton Liveで楽曲を作っていると聞いて、一念発起して新しいPCとAbleton Live 7を購入しました。結局、imoutoidはライブ演奏でLiveを使っていただけで、制作はLogicだったと後から気付いたんですが……。ただ、この時に購入したAbleton Liveのライセンスは、未だにアップデートを続けて使い続けています。

「自分が思いつくことは誰かが先回りして解決している」コミュニティへの信頼感

――DAWの選択肢は多くあったと思いますが、最初にLive 7を選んだ理由を教えてください。

いろいろなDAWの体験版を試しましたが、音がうまく鳴らなくて。Liveの場合は直感的に音が出せたのと、MPCからの移行がやり易いドラムラックの存在が大きかったんだと思います。ワンウィンドウで全ての情報を確認できて、大味な感じでEQやCompを掛けても破綻しない。音楽理論が分からなくても、充実したサンプラー系の機能を使ってループシーケンサーに似た作り方を実践できたので、その頃から「自分のスタイルに合った感覚的なDAW」だと感じていました。ループ系の作り方に慣れ親しんでいたこともあって、最初はセッションビューを使っていましたね。

――現在はアレンジメントビューで制作やライブを行っていると思いますが、セッションビューも併用していますか?

今はアレンジメントビューのみを使用しています。高校3年生からメジャーレーベルの育成部門でコンペ用の楽曲を作ることが増えまして、そこでは全体の展開を俯瞰的に見る必要があったんですね。ループミュージックではなく、むしろストップ・アンド・ゴーのような意識が必要になったので、以来ずっとアレンジメントビューを使っています。

tofubeatsが最近制作中のプロジェクト。

――Ableton Liveはユーザーコミュニティが早くから成熟していた印象を持っていますが、特に参考にしたアーティストやティップスがあれば教えてください。

自分は独学タイプの人間ですから、おそらく皆さんが見ているものと同じようなインターネットの情報や公式チュートリアルしか見ていないと思います。特定の人物や手法を参考にしているわけではなく、あくまで「こういうことがしたい」という発想ベースで、その都度検索を掛けている感覚ですね。

ライブセットを作るたびにMIDIコントローラーのアサインが大変だと思って検索したらユーザーリモートスクリプトがヒットしたり、Wiiのコントローラーを使ってフィルターを掛けたいなと思って検索したら方法が載っていたり、こういう自分くらいが考えつくようなことはギークが先回りして解決しているんですよ。Ableton Liveは柔軟性と拡張性があるし、コミュニティの専門性が高いという信頼感があります。「きっと誰かが既に試しているはず!」という感じですね。

ライブセッティングの変遷

――ここからは『In Session with tofubeats』で語られたライブセッティングやプロジェクト構成についてお聞きします。非常に緻密に組み上げられたプロジェクト構成については動画の方に説明を譲りますが、このセッティングに至るまでの変遷について詳しく教えてください。

ライブをLiveでやり始めたのは……ややこしい表現になってしまいましたが、たしか2010年のWIREからだったと思います。当時は2MIXの所定パートを抜いたマイナスワンを並べただけのプロジェクトでした。MIDIシーケンスを同期させるためにAbletonが走っていて、MIDIクリックを流したTR-707で生演奏をしていました。

エフェクトもリアルタイムに掛けていましたが、どうしても出音がソフトウェアっぽい感じになってしまって、そこから脱却するためにMACKIEのアナログミキサーに全チャンネルを通していた時期もありました。センドリターンで外部エフェクトを使っていましたが、ケーブルだけで20本ほどと機材も多くなってしまったので、運搬がとにかく大変で。

――これはアナログサミング的な考え方ですね。ライブ行脚が多い場合は、機材や荷物の多さはネックになりやすいと思います。

私は「1人で持ち歩けない量でライブをしない」という思想を持っています。マネージャーにも持たせません。自分ひとりでできる裁量を超えない、身の丈にあった機材量が最大でもスーツケース2つ分なんです。その次はRoland/MX-1というデジタルミキサーを導入し、USB1本でステム出しができるようになりました。ただ、このMX-1は、地方都市で万が一壊れてしまうと、すぐに買い直しができません。

もうひとつの思想は「この機材がないとライブができない」という依存性を下げること。極論、誰のPCでも、どのMIDIコントローラーでもライブができるのが理想です。これは制作でもそうあるべきだと思っていて、「これがないと音楽ができない!」という機材は少ないほうが良いと思います。故障時のリカバリーが難しいと思ったため、今のようなインターナルのライブに移行しました。

M1 MacになってAbletonの安定度が大きく向上した実感がありましたので、ここ1年は配信で紹介したシステムでライブを行っています。

――ステムについて、配信ではVOX×2、Mainpart、Bass、RHYTHMの5つに分けていると説明していました。動画ではその下にバス用の『SPECIAL、PAD、INPUT』の3つのトラックが見えていましたが、分類について詳しく教えてください。

自分の楽曲はほぼ全て5つのステムに分けられています。VOXはフェーダーひとつで自分のボーカルが再生されるので、歌詞を忘れたときにフェーダーを上げて助けてもらっています。

SPECIALはMainpartとは別に、特別に分けている音声になります。楽曲に寄ってはリードシンセやリアルタイムに触るソフトシンセなどで、PADは単純にMIDIコントローラーで鳴らすサンプラーですね。INPUTは、今回の配信だと、Erica Synths/Bassline DB-01が繋がっていました。

――Ericaなどの外部シンセはAbletonでエフェクトを掛けるためにトラックとして立ち上げているものと思いますが、ご自身で歌う場合のボーカルはどこに立ち上がっているのでしょうか。

ボーカルはオーディオインターフェイス側のルーティングを使ってPA卓に送っているので、Liveは通っていません。PAにはLiveからの出力音と、ボーカルの2系統が送られています。

これは配信中にもお話したAuto-Tuneが絡んでくるのですが、機材量の関係もあって最近はTASCAM/TA-1VP(ハードウェア・ボーカルプロセッサー。リアルタイムにピッチ補正が可能)を使っておらず、DSPを使用したAntares Auto-Tune Realtime Advancedを使っています。両者ともにアルゴリズムが違って、UADプラグインはもう少しアタック感が欲しいと感じるときもありますが、機材の少なさと、キーを変更するオペレーションが不要なので、ライブセット自体に集中できるようになりました。

――たしかに、ハードウェアを増やす方向性は先ほどのライブ思想とは離れていきますね。ハードウェアの話題で1つだけ気になっていたことがあって、普段マニピュレーターが使うようなオートスイッチャーによるバックアップ体制などは組んでいないのでしょうか?

そういったバックアップは組んでいません。ACアダプターが発熱して動かなくなったり、急に音が止まったりというトラブルもありますが、基本的には会場側にCDJを用意いただいているので、そこが冗長性の部分になります。

自分がLiveの機能と内蔵エフェクトだけでライブセットを組んでいる理由は、どのハードウェアが壊れても絶対にライブができるからです。プロジェクトファイルはDropboxで管理しているため、例えばMacが壊れてしまったとしても、誰かのマシンを借りて、それにAbleton Liveを入れれば即時に復旧ができます。MIDIコントローラーが壊れても、エンドレス・ロータリー・エンコーダの機種でなければどれでも使えます。どれがダメになっても、Liveさえあれば大丈夫なんです!

今回は、セッション内でもお話した現行ライブセットのルーティン部分の雛形になるセッションデータを配布させていただきます。エフェクトラックには一部配布可能なAbleton内部エフェクトを使ったものを搭載しました。ぜひ、ご自身のライブセットやルーティンの参考として役立ててください。

tofubeatsのライブセット用プリセットプロジェクトをダウンロードする

*利用するには、Live 11 Suiteのライセンスまたは無償体験版、および別途Max for Liveデバイス”Outist”のダウンロードが必要になります。

Outistのダウンロードはこちら

*プロジェクトをダウンロード後、zipファイルを解凍し、フォルダを開いたら、Project File > Presets > Audio Effects > Max Audio Effect > Imported 内にあらかじめダウンロードした方のOutistデバイスをドラッグ&ドロップし、フォルダ内のOutistと置き換えてください。こちらのステップを踏んでいただくことでプロジェクトを開くことができます。

どんな現場にも対応するプロジェクトで、最高のライブを!

――Liveプロジェクトの内部の話だと、BEAT REPEATを使ったロールマシーンや、各種FXなどのマスターエフェクトが充実しているのが非常に好印象でした。

打ち込み系のライブはセッティングが全てなんです。リアルタイム感を出すために、臨機応変に何でもできるセッティングを心がけています。シンプルにドラムを抜いたり、HPFを掛けたり、その他細かいエフェクトを自由に設定できるように工夫しています。

DJは、究極的には音質の管理を行う仕事です。いま、どういう音質のサウンドが再生されているかを把握して管理する。「大きい音が流れているとき、一瞬低音が抜けて、また戻ってくると嬉しい!」とか、「もう少し後で盛り上がりますよ」というタイミングでHPFを使って情報に抜けを作って、観客に流れを意識させる。やっていることは情報の抜き差しなんです。

――セッティング自体は動画でも説明していただいていますが、どのエフェクトをどのタイミングで使うかなど、具体的な考え方があればお聞かせください。

「押すか引くか」を観客の様子を見て判断するのが基本です。ここは絶対にこのエフェクトを使おう、という場面はプロジェクトファイルにメモしていますが、最初から全てを決めているわけでは勿論ありません。

上手いDJプレイの言語化はすごく難しいのですが、自分の場合は観客の盛り上がりと自身の楽曲の認知度合いでプレイを決めています。自分のことを良く知ってくれていて、「今日はすごく盛り上がっているなー!」と感じるライブでは、全てのフェーダーを落としてアカペラ一本でも充分に盛り上がります。なんでも歌ってくれる、というときはオケをスッと引く。

一方、自分のことを知っている観客が少ない場合は、しっかりと楽曲を再生した上で「やっている感」のあるエフェクトを多用してリアルタイムに操作している旨をアピールします。この「やっている感」を出す日と出さない日ではプレイにも結構差が出ると思います。

――「やっている感」を出すときに、リアルタイムに大きく変化するエフェクトは重要だと。

そうですね。逆に、オケを引くのはアーティスト側からの働きかけで、「盛り上がって!歌って!手拍子して!」というメッセージなんです。観客がこれをキャッチできていない場合は、淡々とオケを流したほうが良い場合も多いということです。

ライブでは全曲自分で歌うのが前提ですが、サビでマイクを観客側に向けることもあります。こうした場合も、観客の盛り上がりを見ながら少しずつVOXのフェーダーを上げてボーカルを再生する選択を取ることもできます。しっかり準備をして、その場その場で良いプレイをするのが重要ですね。「引く」ときもオケをフェーダーでスパッと切るのか、HPFでハイハットだけ残すのか、ディレイで飛ばすのかで感じ方が変わるので、全トラックに対して任意にエフェクトが掛けられる仕組みは必須だと考えています。

――ここまではライブについてお聞きしましたが、普段の制作についても全てLiveで行っているのでしょうか?

基本的にはLiveを用いています。データの受け渡しやDDP書き出しなどに他DAWを使うことはありますが、最近は「絶対的な必須ツール」も少なくなってきました。Live 11からはコンピング機能も実装されたので、場合によってはLiveでボーカルレコーディングを行う人もいますね。

――内蔵エフェクトを多用している印象もありましたが、制作でも使っていますか?

普段から使うのはEQ EightとCompressor、その次がDelayです。Compressorに関しては最近Glue Compressorも出てきたので、ほとんどなんでもできると思っています。質感付けを伴わないローカット等であればEQ Eightが一番早いですし。移動中にラジオの編集をやることも多いですが、これも全て内蔵エフェクトで行っています。

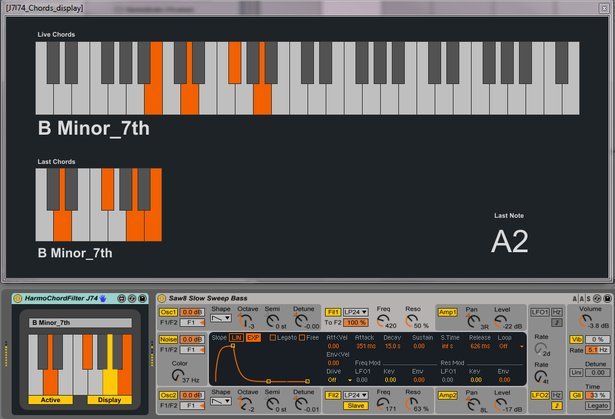

制作という意味では、MIDIエフェクトのPitchも良く使います。鍵盤が上手くないので、Cメジャーに移調して曲を作っているんです。叩いた鍵盤の和音が分かるMax for Liveの「J74 HarmoTools」もシンプルで好きですね。

J74 HarmoTools。

配信でも説明しましたが、オーディオを受けてレベルメーターを表示するEnvelope Followerや、自由度の高いルーティングを実現するOutistなど、とにかく何でもLive上でできてしまうのが魅力なんです。

そして、こうしたMax for Liveを作っていただいている先駆者、ギークの皆様に対する感謝とコミュニティへの信頼が、Liveを使う最も大きな理由です。

tofubeatsの最新情報をフォローしよう:ウェブサイト