Liveを使ってライブパフォーマンスで映像を扱う方法

ライブパフォーマンスでは、視覚的な表現が音楽そのものと同じくらい重要になることがありますよね。 音楽体験と映像体験を自在に操りたいと考えるパフォーマーにとって、Liveはその橋渡し役を務めることができるソフトウェアです。 このトピックは過去の記事やインタビュー、そしてLoopのプログラムでも取り上げられているので、すでにノウハウをたくさん知っているユーザーもいるかもしれませんが、今回は、Liveで音楽に合わせてビジュアルを制作するための技術的なアプローチをいくつか解明しこうと思います。 ここでは、Liveをパフォーマンスの中心に据えている3人のオーディオビジュアル・アーティストに話を聞き、ライブパフォーマンス環境を意図した最近の作品を解説してもらいました。

話を聞いたのは、Max for Live、サードパーティー製の映像ソフトウェア、Live内でのDMX設定による照明操作など、さまざまなツールや手法を駆使するアーティストたちです。 それぞれで求められる専門性が異なるので、自分に合うものを見つけて、ビジュアルをパフォーマンスに取り入れる多数の可能性を探ってみましょう。

Sabina Covarrubias 『Viaje』

Sabina Covarrubiasは、メキシコシティ出身で、現在はフランスのパリに在住する作曲家/マルチメディアアーティストです。 彼女のオーディオビジュアル作品は、視覚音楽、電子音響音楽、電子音楽、交響合唱アルゴリズム写真、リアルタイム音声反応ビジュアルなどの名目で分類されてきました。 最近の『Viaje』は電子音楽と自動生成ビジュアルで構成された42分間のライブ作品で、モジュラーシンセとボコーダーによる音声と並んで、Jitter(Max/MSPでビジュアルを制作するために使われる一連のオブジェクト)で作ったビジュアルが使われています。

Sabina Covarrubias『Viaje』

CovarrubiasがJitterの使い方を学び始めたのは、パリ大学の博士課程で作曲のためにマルチメディアを用いる研究を行っているときでした。 音を視覚的に表現することへ興味を増していった彼女は、IRCAM(フランス国立音響音楽研究所)で専攻としてJitterと出会います。 そんなCovarrubiasがMax for Live内でJitterをどのように使用して『Viaje』のビジュアルを制作したのか、詳しく見ていきましょう。 オーディオビジュアル制作入門の手引きとして役立つチュートリアルビデオ(英語)や無料のMax for Liveパッチも提供されています。

まず、『Viaje』を制作するアイデアになったものについて話を聞かせてください。あと、それがどのように音楽面と視覚面で変換されているのかについても教えてください。

Viajeは、“旅”という意味です。 この作品の場合だと、“魂をめぐる旅”を意味していて、シャーマニズムの考え方に触発されています。 わたしの両親は、あるシャーマンの名前にちなんでわたしをSabinaと呼んでいたんですよ。 わたしは専門家ではありませんが、シャーマニズムでは、“旅”は自分の魂を探求するための手段だと言われています。 この作品の意図は、自分自身の中に“旅”を作り出すことでした。でも、作品の説明にそう書きたくはないです。なぜなら、各自で好きなように想像してほしいからです。

この作品は複数のセクションで構成されていて、各セクションが旅の1場面に相当します。 ある意味、これは混沌から秩序への旅を意味していて、作品は音楽的にも視覚的にも同じように構成されています。 合計で6枚のイメージがあるんですが、全部がまとまるようにつなげています。

音楽と映像はどのように関連しているんでしょうか? 最初に取りかかったのは音楽のアイデアと映像のアイデアのどちらでしたか? それとも両方を並行して進めていたんでしょうか?

わたしが作曲をするときは、音声のアイデアが映像と一緒になっていることがとても多いです。 だから『Viaje』を録音していたときは、先に音声から始めてはいるんですが、それに伴う映像をすでに想像していました。

おぉ。 どんなものをイメージしていたんですか? 形状とか色でしょうか?

具体的なものではありませんが、たとえば、カエルのいる湖みたいに聞こえる部分があったので、動物とかジャングルとか、自然に関連するものをイメージしていました。 なので、その部分の映像では、鳥の動きを模倣するBoidsというアルゴリズムを使って作業しました。虫やハチが飛んでいるようになっていますよ。

Boidsと呼ばれるアルゴリズムを使ったセクションの静止画。

音声を聞いて映像をイメージするのは、自然にそうなったんでしょうか? それとも時間をかけて培ったものですか?

自然にそうなったと思います。でも、わたしの音楽経歴やオーケストラの編曲レッスンにも関係していますね。 オーケストラの編曲の概念を理解するために、わたしは頭の中でイメージしなきゃならなかったんです。 それの役にたったのが、子供の頃に見た映画『ファンタジア』でした。音と映像がすごく近いんですよ。 そうしているうちに、何かを聞いていると、その音を想像で可視化していくことが自然にできるようになりました。

『ファンタジア』は、すごくいい例ですね。もう一度、見てみたいです。 『Viaje』では、どれくらいの音声と映像が即興で作られているんでしょうか? ライブパフォーマンスでの即興について、こだわりはありますか?

映像や音声の一部はあらかじめ録画/録音されていますが、ライブパフォーマンス中に変化させられる要素もあります。ボコーダーと打楽器です。 建物の構造に似ていて、作品を構成する柱となる部分は絶対に変わりませんが、途中でパーツを長くしたり短くしたりすることはできます。

『Viaje』のライブパフォーマンスでは、音声用と映像用でどのような機材を使っているのか教えてください。

公演の内容にもよりますが、 即興パフォーマンスに柔軟性を持たせたい場合は、Liveを使います。変化の少ない音声でやりたい場合は、モジュラーシンセだけでやりますね。

モジュラーシンセを使う場合は、Nvidia GTX 1070 GPUを搭載した15インチの専用ラップトップで映像を処理します。Alienwareのラップトップです。 そのラップトップでスタンドアロン版のMaxを起動して、映像をリアルタイムで処理するMax/MSPのパッチを使います(スタンドアロン版のMaxの入手方法は、Max for Liveと異なります)。 音声は、モジュラーシンセだけでやっています。IntellijelのモジュラーPlonkを2基、Mutable InstrumentsのPlaits、2HPのKickで打楽器を鳴らして、ボコーダーにはRolandのVP-03を使います。あと、録音しておいたパートを再生するために1010 MusicのBitbox mk2を使います。 これでやるときは、映像と音声は独立しています。

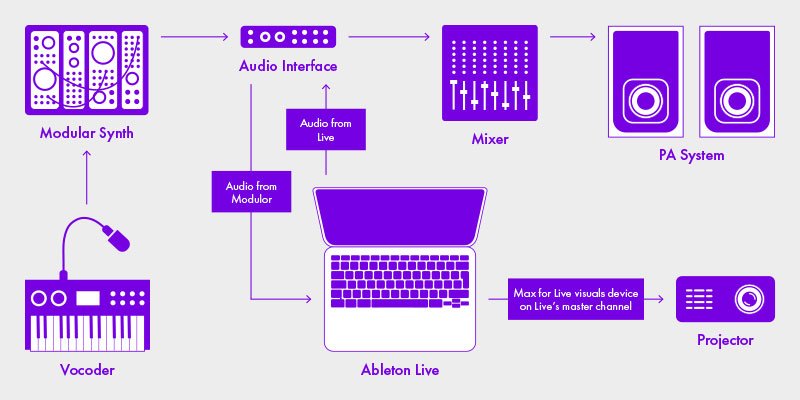

ライブパフォーマンスを即興的にしたい場合は、Liveでやります。柔軟性が高いですからね。 さっき話したモジュラーシンセを使う場合だと、複数のモジュラーシンセの音が混ざった状態になるんですが、Liveを使う場合は、大部分をミックスしないままにしておくことができるので、さまざまな場面で鳴らす音を決められます。 Liveを使うときは、Liveを入れた1台のコンピュータで音声を処理します。Max/MSPのパッチに手を加えて、それをMax for Liveエフェクトとして実行して映像を処理するんです。 モジュラーシンセの出力をLiveのトラックに入力して、そのトラックにMax for Liveデバイスを入れて映像を生成しています。

Sabina Covarrubiasのライブパフォーマンスで使う機材の配線図。

Liveを使って音声と映像を処理しているとき、CPUの負荷に悩まされることはありませんか? AbletonやMaxでCPUの使用を最小限に抑えるために何かしら提案はありますか?

難しいトピックですね。わたしが見つけた解決策は、OpenGL(英語)というオブジェクトを使ってMaxのパッチを可能な限りプログラミングすることです。そうすれば、コンピュータのGPUを代わりに使えるので、CPUや音声処理の容量を空けることができます。 だから、高性能のGPUを使うことがわたしにはとても重要なんです。

Max for Liveを使って映像を生成することには、ほかの映像専用ソフトと違って、どのようなメリットやデメリットがあると思いますか?

Live内でMax/MSPを使うメリットは、ふたつのプログラムの潜在能力を掛け合わせられることです。 Maxには、音声解析やMIDI解析を行うための専用オブジェクトが用意されているので、プログラミングの知識がそんなになくても、ユーザーはすぐにおもしろいものを作り始めることができます。

Liveは頭脳みたいなものなんですよ。情報をシンセに送ってシンセを操作し、その情報をMax for Live経由で映像用に供給するっていうことが、すべてLive内で行えます。 Liveの送る情報がどんなものでも、それをMax for Liveで処理できます。

MaxやJitterを使って映像を作る方法を教えてきた経験がありますよね。 これからLiveを使って映像を始めようとしているミュージシャン全般にアドバイスはありますか?

Max for Liveの世界をひとつずつ知っていって、Jitterを理解していくのが一番だと思います。 わたしのウェブサイトでは、JitterとOpenGLを使ってMax for Liveデバイスを作成する方法を資料にしてまとめています(英語)。 そこから始めて、そのあとにJitterを習得してみてください。あと、Max for Liveを使ってLive内で処理する映像をプログラミングするときは、いつもglobejectsを使うようにしましょう。そうすれば、大切なCPUの使用量を節約できます。

Jess JacobsとPussy Riot

Jess Jacobsは、音楽技術者、ミックスエンジニア、マルチ楽器演奏作曲家、パフォーマー、そしてプロデューサーとして、事あるごとに複数のジャンルを融合しながらロサンゼルスを拠点に活動しています。 彼女には、2020年にツアーがすべてキャンセルされるまえにコラボレーションを開始していた相手がいます。ロシアのパンクバンド/フェミニスト・パフォーマンスアート集団、Pussy Riotです。 今回は、Pussy Riotでクリエイティブの構想を担当するNadya Tolokonnikovaの見解を交えながら、Jess Jacobsの担う多くの役割を垣間見ることができました。 今後のツアーに向けてどのようにビジュアルを共作したのか見ていきましょう。

Nadya、今後予定しているPussy Riotのパフォーマンスの構想について教えてください。それをどのように舞台上の世界観で反映するんでしょうか?

Nadya:すごく視覚に訴えるパフォーマンスなんです。 音楽ももちろん重要ですが、わたし個人やPussy Riotのメンバーにとっては、ビジュアル面はいつも音楽と同じくらい重要な要素でした。 ときには、従来の音楽コンサートというよりも、オーディオビジュアル・パフォーマンス作品だと自分たちで言うこともあります。

映像コンテンツはどのように決まったんでしょうか? 映し出す素材をどこで得ていますか?

Nadya:場合によりますね。 普段、インターネットで手に入れることはしていませんが、もしそうする場合は許可を取っています。 ほとんどは自分たちで撮影したものです。 わたしは監督とカメラの操作をやっています。 ほかに撮影監督がいる場合もありますが、編集や色補正もわたしがやります。 自分の映像の大部分は自分で作業していますね。例外は30%くらいで、ビジュアルアーティストとコラボレーションするときです。アルゼンチンからロシアまで世界中のアーティストとやっていて、シベリアの僻地の人ともやったことがあります。

自分の世界観をどのようにJessに伝えましたか? コラボレーションがどのようなものだったのかも教えてください。

Nadya:圧倒されましたね。 わたしが「えーっと、これとあれと、あとあれもやらなきゃな」って感じだったら、Jessは「じゃあ、こういうふうにやってみようよ」って言ってくれたんです。実は、映像、照明、音楽を同時に操作できる人を見つけられると思っていませんでした。そんな人を見かけたことがなかったので。 以前は、映像を担当する人、照明を操作する人、音声を担当する人の3人と一緒に移動するのが普通でしたが、どういうわけか、Jessはそれを全部やることができたんです。

どんな流れで作業したんでしょうか?

Nadya:どうなんだろう。Jess、流れってあったっけ? どのパフォーマンスもかなりカオスです。 メンバーがふたりのときもあれば、20人のときもあります。 Pussy Riotに関してだと、決まったものがあるとは言えないですね。その場に応じてやっています。 流れっていうようなものはないですかね。 だから、わたしたちがやっていることに計画的な雰囲気をもたらすのがJessの役割になっていると思います。 それが役立つのがツアーのときですね。単発公演であれば、わーって全部を最初から作り上げることができますけど、ツアーで毎日パフォーマンスする場合だと、それが難しくなりますからね。

Jess:カオスをきれいに整える、みたいな(笑)。

ということは、映像と音楽に具体的なつながりがあるように思えるんですが、 コンサートでは、表示する映像と歌っている歌詞は対応しているんでしょうか? それとももっと抽象的ですか?

Nadya:対応しています。 わたしたちは、オーディオビジュアルのプロパガンダを作っているんですよ。自分たちの先進的ですばらしい価値観を伝えるためのプロパガンダを。 理想的なシナリオは、Pussy Riotの公演に来た人が帰り際に、抗議活動をしたい、地方自治体の建物を占拠したいと思ってくれることですね。 なので、その行動をみんなに喚起させることができれば、いい仕事ができたって思えます。 それは、多くの意味で、でかでかとした挑戦的な文字に頼ることになりますけど、その文字が歌詞のとおりである必要はありません。 歌詞のメインアイデアであったり、演奏を見たり聞いたりした人に自問してもらいたい質問であったりしてもいいんです。 つまり、オーディエンスの行動を促す相互作用になるなら何でもってことですね。

特定のムードにできるものなら何でもいいんです。かなり暗いムードになることが多いんですけどね。わたしたちが歌っているのは、警察の残虐行為みたいな深刻な政治問題や気候破壊についてなので。 でも、突然お祝いの映像や歌でびっくりさせてポジティブな雰囲気で終了することもありますよ。コンサートから出てきた人たちが打ちのめされるほどネガティブなムードになってほしくないので。 そういうのって、ニュースを読んで感じることのような気がします。 わたしは暗いムードにしたいけど、自分たちの行動や態度を変えることをつうじて希望で満たしたいとも思います。そして、連帯感でわたしたちは救われるんだと知ってもらい、ネガティブなムードを克服しやすくしたいですね。 Pussy Riotのパフォーマンスを見たときに、音楽と映像の組み合わせからオーディエンスが感じるのは、そういうものであってほしいです。

Pussy Riotのメンバー。 右から、Nadya Tolokonnikova、Bita Balogh、Rachel Fannan、Maria Baez。

Jessはここ数年でおもにサウンドエンジニアとして活動してきましたが、Pussy Riotとの活動では役割が増えていますよね。 今後のPussy Riotのパフォーマンスで担っている役割をそれぞれ説明してもらえますか?

Jess:どんどん増えているっぽいです。ほぼ毎回、映像の再生と一緒に客席側でのPAも担当しています。それがいつも一部になっていますね。 最新作だと、間違いなく照明と映像の担当になります。 わたしがResolumeとかVJのものに手を出したのは、それが初めてです。 で、わたしはツアーマネージャーとプロダクションマネージャーをやりました。 プロダクションマネージャーっていうのは、Nadyaやチームがやりたいことを汲み取って、それを実現するために必要なものをすべて発注します。 わたしは同行せずにみんなが飛行機で向かった先のフェスティバルであっても、わたしが直接参加するイベントであっても関係ありません。 特定の機材が必要な場合、それを手配するのがわたしです。 ラップトップ・コンピュータの調達とかね。 ステージで必要なものをどうやって割り出すか、 それをどうやってつなげるのか、 そういったことを俯瞰的に判断するっていうか。

その一環で、観客側でミキシングをやっています。 観客側からモニターのミキシングをしていますね。 ギターとキーボード担当のMariaが映像を作動していますけど、全部のステム・ミキシングはわたしがやっていて、コンピュータの準備も最初からやります。 インストールや設定も全部ですね。

照明をLiveでプログラムすることもやっています。映像のキューもLiveでプログラムします。 だから、いくつの役割をやっているのか、もうわからないですね。

あと、すべての映像素材を取り込んでResolumeに入れることもやっています。配信の面倒や全体をまとめることもやって、自動化したり、どうなるか予想できるようにしたりして、間違いが起こらないようにしています。

つまり、Jessが舞台裏のことを全部やっていて、公演中はPAを担当して、ギター担当がリアルタイムで映像を作動しているってことですか?

Jess:そうです。設定を組んでいるので、すごく楽ですよ。 わたしたちはSetlistを使っています。Strange Electronicsのプラグインですね。それをLiveで使います。Liveが中心となっているので、LiveからMIDIノートが必要な人に送信されます。 それがDMXボックスであろうと、Resolumeであろうと、Nadyaのサブベースシンセのパッチチェンジであろうと、何でもです。

カリフォルニア、ロサンゼルスでツアーのリハーサルに臨むPussy RiotのメンバーMaria Baez。

どんな経緯と理由でライブパフォーマンスのビジュアル面を担当することになったんでしょうか?

Jess:やらなきゃいけないことだったってだけですよ。 基本的に、わたしはどんなプロジェクトでも「ノーとは言いたくない」という態度で臨みたいと思っています。だから、可能な方法があるのであれば、もしくは自分で方法を考えたり、調べて方法を見つけられたりするのであれば、それはできるってことです。

以前は、Liveで実際の映像ファイルを使って作業をしていたので、その時点でハードウェアの安定性が心配でした。1台のコンピュータで映像と音声を扱うのは大変ですからね。 過去に映像の再生を扱う経験がたくさんあって、大きな問題を目の当たりにして解決してきたので、そういうことには批判的な意識になります。 あと、ソフトウェアエンジニアとして、コンピュータの性能も意識しますし、コンピュータを冷却してリソースの消費を低く保つことにも気を配っています。 みんなが来たときにわたしが言ったのは「これは分割して、独立した映像用のラップトップに入れないとだめ。それで、どんな場所でも簡単に設定できるようにしないと」ってことでした。 今年はフェスティバルや移動日がとんでもなく多くなる予定だったので、何でも簡単に設定できるようにしないといけないってわかっていましたし、VJや照明デザイナーを雇う予算もなかったので、自分たちで方法を考えました。

ライブパフォーマンスで使っているいろんなビジュアル要素について説明してもらえますか?

Jess:もちろんです。 わたしがいつも可能な限り追い求めるようにしているのは、公演での信頼性と再現の容易性です。 みんなで照明がどこかに欲しいと思っていて、少なくともストロボは入れたいなって考えていたんですよ。 それ以外の照明の演出は、非常にシンプルでわかりやすいものです。 フロントの照明やムービングライトは一切ありません。その狙いは、映像をしっかりと見せることにあります。 Nadyaが言ったように、映像はパフォーマンスの重要な一部ですからね。 ある場面を強調したいと考えていたので、ストロボを2~3台用意してくれってNadyaから頼まれて、そこから考えていきました。 ステージの大きさに応じてストロボは2~4台あります。ストロボは白色か赤色か青色になります。複数の色にしているので、曲の色調に応じて使い分けられます。 で、本番のリハーサル中にみんなで一緒にセットを見なおす日を設けたんです。そうしたら、Nadyaがストロボを欲しい場面を言ってきたので、それをわたしがプログラムして、って感じでした。

それが照明の話で、あとは映像ですね。 映像を投影するスクリーンがあったり、フェスティバルだとLEDの壁があったりしました。 わたしたちはResolumeを実行するラップトップをプロジェクターに接続していて、それが映像を構成する要素になります。

ほかにもありますよ。 (楽器スタンドを指差して)このテーブルみたいにたくさん装飾があるし、あとPussy Riotの合図用テープもあります。 卓上の照明もありました。パフォーマンスをつうじて点いたり消えたりするサイレン2~3基とか。でも、それは自動化していないです。

ダンサーもいます。 ダンサーは常にいますね。

Ableton Live内はどんな構成になっていますか?

Jess:こういうことではアレンジメントビューで作業するほうがいいですね、グループの特性上。 Nadyaも言ったように、統制されたカオスなんです。 たとえば、サウンドチェック中に何かを変えたいという人が出てくることもあるんですけど、だからこそセッションビューを使わないんです。どんどん変わってしまうから。 なので、わたしたちはアレンジメントビューを使っています。アレンジメントビューでは、プラグインのSetlistを使うことも可能です。 Setlistを使うのがすごく好きなんですよ。Liveセット内で曲の位置を変更するのがとても簡単になるので。とにかく超シンプルです。

なので、使うのはアレンジメントビュー、 それでロケータを設定して、 それをSetlistで使います。 MIDIトラックでは、照明用のエンベロープを描いていて、それが必要に応じて変わります。 照明が必要なときは該当するエンベロープが上がるようになっていたり、色を変える必要があるときは各色のエンベロープが推移したりするようになっています。

あと、RTP MIDI経由でMIDIノートをResolumeのラップトップに送って映像を作動させています。曲の最初からそうしていますね。 VJの感じとは違いますよ。VJはいろんなテクスチャーを再生してそれを混ぜ合わせるとか、そういうことをやっていて、 「この曲にはこの映像」って感じなので、映像を再生したら、あとはそのまま。

オーディオとビジュアルの両方を操作するのは、今回のプロジェクトが初めてですよね。やってみてどうですか? オーディオとビジュアルの全体像がわかるというのは、いいものですか?

Jess:ですね。かなりいいです。 Pussy Riotのために組んだものですが、そのあと自分の配信でも使うようになりました。 オーディオビジュアルを上級者向けレッスンで教えたり、配信番組やミュージックビデオをやっている友人の相談にのったりもしています。 わたしは、全部をひとつの場所に集約するのが好きなんですよ。 従来の方法でやるとしたら、照明卓にもっとお金をかけて、その卓を置くスペースを確保して、操作方法を学ばないといけません。もちろん、そのほうが洗練度とパフォーマンス性が高いですよ。だからこそ、照明デザイナーがそこに座って公演を盛り上げたり、彩ったりするわけです。

わたしが自分の公演の舞台設計をやるときは、MIDIコントローラを使って照明を操作するところから始めます。照明の表現に必要なエンベロープで全部の色を操作できるようにMIDIコントローラをマッピングしています。でも、全部をひとつの場所にまとめるほうが好きですね。ソフトウェア・オタクな観点から言わしてもらうなら、わたしが操作するプログラムは1種類で十分だからです。 リソースを消費して安定性を心配し始めるくらいなら、1台のラップトップで4つのプログラムを実行する必要はないです。 それに、編集の利便性を考えれば、タイムコードをどこかに送らなくていいので、同期がずれることもないですよね。 そうじゃなくて、全部を手元にある状態にしておけば、映像が間違っていてもMIDIノートを動かすだけで大丈夫です。

Resolumeを実行している2台目のコンピュータとデータのやり取りをするときに、RTPを介したMIDIが一番だと判断した経緯と理由を教えてください。

Jess:まず挙げられるのは、RTPは無線でも有線でも利用できることですね。 わたしは有線がよかったんです。無線でもいいんですけど、無線ルーターを誰かにハッキングされる可能性があるのは嫌だったんです。それが、理由のひとつですね。 あと、ネットワークの遅延で台無しになることも避けたかった。 プラグインもありますけど、RTP MIDIになるだろうなと思ってました。そのほうが好きだからです。 何かしらプラグインを読み込んでおくのとは違って、シンプルかつ低コストでMIDIノートを処理できますね。

Abletonで再生操作を行うときは狂ったように整理しています。というのも、プラグインを追加して、それがどれほど多くのリソースを消費しているか知らなかったせいで壊滅的な問題が発生したことがあるからです。 EQやAuto Filterとか、そういうものさえも使うことがほとんどありません。 すべてを最小限に保っています。 編集して書き出しなおして、Liveで行うことが、WAVファイルの再生とかMIDIノートの再生とか、ひとつだけの状態になれば大成功です。 2台のラップトップがステージ上にあって、わたしが観客の後方でミキシングをしているという状況だと、何か問題が発生した場合、復旧に数分はかかってしまいます。そういう状況がいつも一番ストレスになりますね。 なので「MIDIノートだけを鳴らそう。それでいい」って感じでした。

Pussy Riotのためにこのシステムを構築してから、それの代わりになるツールや作業方法はありましたか? 照明や映像に慣れていない人でもすすめられるものがあれば、教えてください。

Jess:むしろ、照明のプログラミングをさらに発展させてますね。 自宅にはもっと照明があって、ツアーに持っていくよりも多くの数があります。そこにMIDIコントローラを追加していますよ。 どんな人にも提案するなら、MIDIコントローラのマッピングを活用することですかね。 わたしはAkaiのMPKやAPCスタイルのコントローラを持っていて、 片方に8つのノブがあって、もう片方に9つのフェーダーがあるので、それを使って照明を操作しています。 感覚をつかんだら、曲を聞きながら操作して、それを記録します。 先日の公演(上、参照)でもそうしました。 以前はやっていなかったんですけど、絶対におすすめです。9種類のエンベロープに合わせて手動で操作するよりも断然とっつきやすいですよ。 そういうのはすぐに飽きてしまいますからね。

Pussy Riotの公演でプログラミングしたあとにわかったことがもうひとつあって、セッションビューでサンプルとかループとかを再生してパフォーマー的にLiveを使っているなら、クリップスロットにMIDIクリップを入れてちょっとしたエンベロープを描けるんですよ。 サンプルを再生すると同時に照明も作動させられるので、セッションビューでループやワンショットとか好きなものを演奏するみたいに照明を演奏することができます。 あと、クロスマッピングも可能です。 DMXISボックスに適切なエンベロープを送信すればいいだけの話なので、いろんな方法で行うことができます。 言ってみればサイドチェインに近いものがありますね。データをある場所から別の場所に取り込んでDMXISボックスに渡すだけで、すごい効果を生み出せますよ。

CLAUDE『Synapse』

韓国のソウルを拠点に活動するオーディオビジュアル・アーティストCLAUDEは、 リアルタイムのデータにもとづいて、有機的で抽象的なデジタル生成物やグリッチ音を制作し、アーティストである自分自身と観客の間にあるオーディオとビジュアルの境界を壊すことを試みています。 そんな彼が手がけた最近のオーディオビジュアル作品のひとつ『Synapse』は、人間の記憶や感情に現れる抽象的なイメージ、そして、複数の有機体や細胞の間で神経の複雑な動きの中に現れる抽象的なイメージを具現化したものです。

音楽のためのビジュアルを制作している経緯を教えてください。 どのようにTouchDesignerを使うことになったんでしょうか?

僕は常にライブパフォーマンスに興味があって、 電子音楽を作り始めた頃から、自分の作品をパフォーマンスで表現する方法を探していました。 子供の頃からアーティスト的だったので、自分のパフォーマンス中に見せる映像は自分で作るべきだと考えました。 おもにAbletonのYouTubeチャンネルやTouchDesignerの公式ページをたくさん見たり、コミュニティに参加したりしてオーディオとビジュアルのパフォーマンスを独学で勉強しているとき、2017年のMutek Tokyoっていうフェスティバルに行って、そこで見た多くのアーティストがTouchDesignerを使っていることを知ったんです。 自分の音楽にリアルタイムで反応するビジュアルを作れるっていうことに興味を引かれて、すぐに深くのめり込んでいきましたね。

『Synapse』は何を表現しているんでしょうか? そして、それを音声と映像でどのように反映していますか?

『Synapse』で意図しているのは、人間の記憶や感情、生命の構造を再考してもらうことです。 Liveで生成した音声信号をリアルタイムで映像に作用させて、映るものの形状を作ったり、変形したりしています。

リアルタイムな情報をもとにして映像を生成するという処理も行っていると聞いたんですが、 どのような情報を使っているんでしょうか? そうしたテクニックは音声と映像の両方に取り入れていますか?

ネット上で見つかるリアルタイムの自然情報を利用しています。たとえば、いろんな国の気候や水位とか。 そのデータをエクセルで分析して整理したあと、割り当てたOSCメッセージをTouchDesignerに送信します。 このOSCメッセージは、Liveに送ることもできます。 そうするとデータを使ってリアルタイムでコンテンツを操作できるようになるので、音作りのアルゴリズムや映像作成に使います。

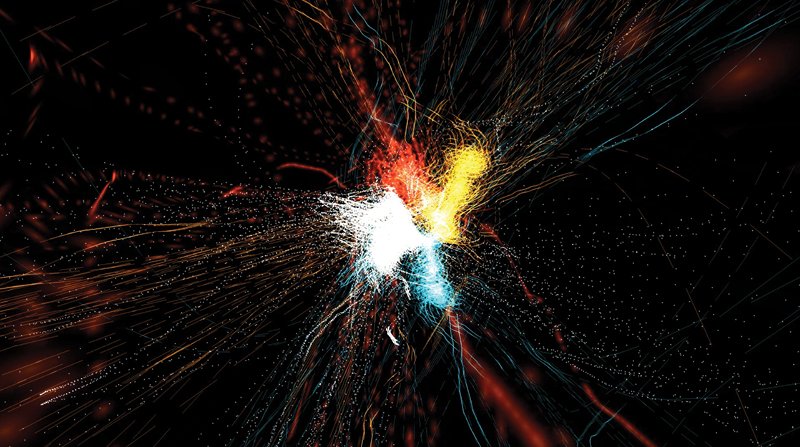

『Synapse』のワンカット。細胞のつながりや人間の複雑な神経を風景として表現している。

ライブパフォーマンスでは、Ableton Liveと同じコンピュータで映像を処理しているんでしょうか?

それぞれで別々のラップトップを使っています。 1台は音楽用、もう1台は映像用です。 その2台のコンピュータは、WIFIかLANケーブルを使ってOSCでデータをやり取りします。 OSCでデータをやり取りするために別途プログラムを使っているわけではなく、TouchDesignerのOSC入出力とMax for Liveだけを使っています。

Max for LiveデバイスのGrabberSenderを使って、TouchDesignerとAbleton Live間のデータのやり取りをOSCでやっているそうですが、 そうしている理由を教えてください。

個人的には、MIDIよりもOSCを使ったほうが細やかで便利だと感じています。 GrabberSenderを収録しているLiveGrabberを使えば、Liveで使うほとんどのパラメータやMIDIノートをOSC信号に変換できます。 これは、オーディオビジュアル作品を制作するうえで無限の可能性を秘めています。 いちアーティストとして僕が使っている理由は、自分の創造性を制限することがないフォーマットだからです。

ワシントンDCのArtechouseで『Synapse』のパフォーマンスをしたあと、パフォーマンスを行う会場の空間の重要性について話をしていましたよね。 『Synapse』のパフォーマンスを行ううえで同会場が完ぺきだったのは、具体的にどのような理由からでしょうか? 理想の会場はどんな空間ですか?

アーティストには、作品をつうじてオーディエンスに表現したいことがあって、そのためには会場がとても重要になります。 Artechouseは360度の没入型空間で、『Synapse』のパフォーマンスを行うには本当にすばらしい場所でした。『Synapse』は、人間の記憶や生命の構造をテーマにした作品だからです。 映像と音声を介して作品に没入して、オーディエンスを圧倒しないといけません。 大規模な没入型会場であっても、すごく小さなスペースであっても、アーティストのビジョンをもっとも表現できる空間がもっとも理想的な場所です。

ライブパフォーマンスに向けて映像の世界を探求したいと思って、これから始めようとしているミュージシャンにアドバイスはありますか?

まず、何を表現したいのかを考えることですね。 音楽がもたらす影響とか、それによって伝えられる内容っていうのは無限にあるんですけど、映像を作品で使い始める瞬間は、作品に対して具体的な焦点を定める機会になります。 わかりやすいものでもいいですし、抽象的なものでもいいんですが、まずは、オーディエンスに何かを感じてもらう部分はどこなのかをじっくり考えてみましょう。

文/インタビュー:Angelica Tavella