So, wie sich Musik und Musik-Technologie ständig weiter entwickeln, so macht diese Entwicklung auch vor den Institutionen nicht halt, die Musik und musikrelevante Disziplinen unterrichten. Das Tempo in akademischen Kreisen ist jedoch eines, das mit dem Fortschritt in der realen Welt kaum mitzuhalten vermag. Ein Grund dafür ist sicherlich, dass Konservatorien und Musikhochschulen ihre Methoden und Konzepte nur äußerst ungern an die neuen Gegebenheiten des technikbasierten Musikmachens anpassen.

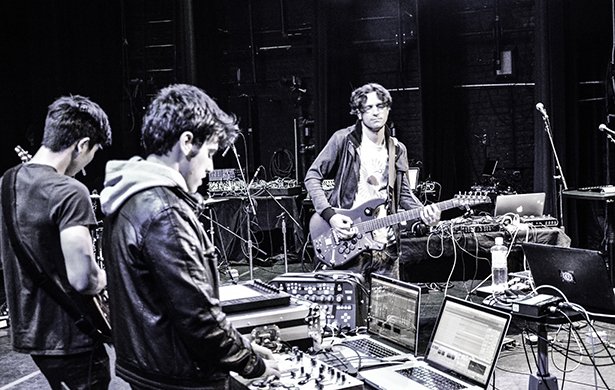

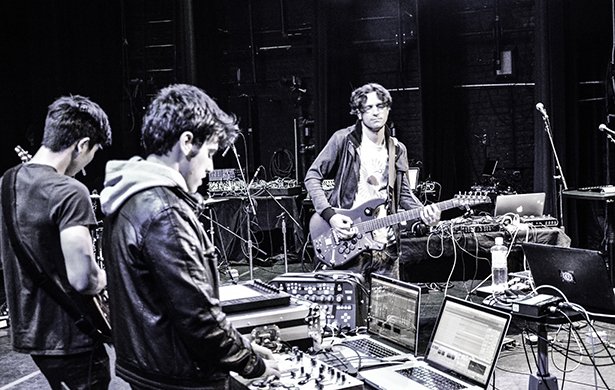

Eine Einrichtung, die sich diesem Trend entschieden widersetzt, ist das Electronic Production Design Department des Berklee College of Music. Das vom langjährigen Dozenten und Musiker Michael Bierylo geleitete EPD-Programm kombiniert die Fächer Performance, Komposition, Orchestration und lehrt mit Computer, Synthese und Multimedia-Technik. Wir sprachen mit Michael Bierylo über die heutigen Herausforderungen, ein zeitgemäßes Studium auf die Beine zu stellen und gleichzeitig – unter argwöhnischer Beobachtung – althergebrachtes Denken mit Paradigmenwechseln innerhalb der Lehre aufzubrechen.

In einigen Bereichen der Musikwelt hat der Laptop mittlerweile seine Daseinsberechtigung als eigenständiges Instrument erlangt. Wirkt sich diese Entwicklung auch auf die Lehrpläne für das 'Electronic Production Design' bei Ihnen am Berklee College aus?

Der Aspekt, dass ein Laptop mittlerweile auch als eigenständiges Instrument angesehen wird, ist für uns ein echtes Thema. Wir müssen eine Definition entwickeln, um die Einordnung vornehmen zu können. In einem institutionellen Haus gelten nun mal bestimmte praktische Regeln. Wie zum Beispiel soll das Vorspiel eines Laptop-Musikers aussehen? Welches "Standard-Repertoire" sollte man beherrschen? Wie bewertet man Fähigkeiten und welche Kriterien muss man für die Abschlussreife erfüllen? Was ich damit sagen möchte: ein Laptop genauso zu sehen wie die eher traditionellen Instrumente, wird nicht sonderlich gut funktionieren. Wir kommen nicht umhin, die Definition zu aktualisieren, wie ein Musikinstrument beschaffen ist. Und darüber ließe sich wohl ewig referieren.

Meine Gedanken kreisen um ein paar grundsätzliche Feststellungen:

- Der Computer ist dabei, das Klavier als Mittel der Wahl beim Musik erlernen und entwickeln abzulösen. Wenn heutzutage jeder nur vorstellbare Sound musikalisch spielbar wird, dann ist das Klavier als Basis und Referenz zu limitiert.

- Der Rechner allein macht noch kein Instrument. Erst in Kombination mit Software und Hardware-Controllern sind die Vorraussetzungen erfüllt. Aber der Computer ist und bleibt die Plattform für das Design neuer elektronischer Instrumente.

- Das Entwickeln von Instrumenten ist Teil der Performance-Praktik. Und jeder Einzelne plant und realisiert sein ganz eigenes System. Dadurch entstehen völlig individuelle Lernkurven. Das ist mit dem Erlernen eines Repertoires auf der Gitarre nicht zu vergleichen. Vielmehr geht es um die Gestaltung eines Instruments, welches Sounds und Stimmungen so produziert, wie sie dem Komponisten oder Performer vorschweben. 'Electronic Production Design' unterrichten wir am Berklee im Prinzip schon seit den späten 80ern, damals hieß es noch 'Music Sythesis Department'. Wahrscheinlich waren wir die ersten, die einen Abschluss mit dem Fokus auf elektronische Instrumente in Aussicht stellten.

Sehen Sie diesbezüglich ein steigendes Interesse bei Schülern, die traditionelle Instrumente erlernen oder Komposition studieren? Verhilft der Computer als Instrument jungen Musikern mit klassischem Background zu einer breiteren Sicht auf Sounds und Musik ganz allgemein?

Für gewöhnlich haben die Studenten der traditionellen Fächer im Vorfeld schon ein paar Erfahrungen mit der Musikproduktion am Rechner gemacht, obwohl die meisten von ihnen wohl angeben würden, sich technisch noch nicht sehr sicher zu fühlen. Es gibt ungefähr drei Ebenen, auf denen die Schüler mit Technik beim Studium der Musik interagieren. Als die ersten Studenten hier am Berklee Laptops bekamen, konnten wir vor allem eins beobachten: Fast alle begannen, ihre Noten vom PDF abzulesen. In jedem Ensembleraum, den man betrat, stand ein Laptop mit Spielanweisungen. Auf YouTube findet man soviel von der Musik, die unsere Schüler hier studieren; in vielen Fällen sogar Clips mit Anleitungen, wie sie gespielt wird. In dieser Hinsicht hat der Computer den Studenten ein breiteres Spektrum im Umgang mit den Prinzipien traditioneller Instrumente vermittelt. Das unterscheidet sich aber nicht sonderlich davon, wie der Rest der Welt Technik für das tägliche Lernen nutzt.

Wenn Ihnen dann bewusster wird, dass der Rechner tatsächlich eine enorm große Rolle dabei spielt, wie die akustische oder elektronische Musik, die sie später einmal machen wollen, entsteht, rückt auch der Produktionsprozess mehr in ihren Fokus. Für unsere Studenten ist das 'Aufgabenpapier' oftmals ein Track. Die Fähigkeit, musikalische Ideen auszuformen, ist für die Kommunikation dieser Idee und den weiteren Austausch enorm wichtig. Die Produktion ist Teil des Kreativitätsprozesses, egal ob subtil oder komplex, und wir stellen fest, dass die Studenten diesen Wert erkennen und wissbegierig sind.

„In der Klavierstunde lernst du aber nicht, einen LFO mit dem Tempo zu synchronisieren, obwohl das eine essentielle Fertigkeit beim Schreiben und Produzieren moderner Musik ist.“

Beim traditionellen Arrangieren kennen wir die Limits tiefer Intervalle, die zu Problemen im Timbre führen, wenn tiefe Noten eng aneinander gesetzt werden. Beim Produzieren sprechen wir darüber, warum eine Produktion beim Einsatz bestimmter Sound-Gruppen im unteren Frequenzbereich "mumpfig" klingt. Selbes Thema also, aber ein anderes Herangehen, das fundierte Kenntnisse über Sound und Produktion voraussetzt, um effektiv zu sein. Einige Studenten erreichen durch das Liebäugeln mit elektronischen Sounds und elektronischer Musik ein nochmals höheres Kompetenzlevel. Es gibt eine Vielzahl musikalischer Techniken, die rein elektronisch sind – Wobbles, Drops, solche Sachen – und unbestritten zum musikalischen Vokabular gehören. In der Klavierstunde lernst du aber nicht, einen LFO mit dem Tempo zu synchronisieren, obwohl das eine essentielle Fertigkeit beim Schreiben und Produzieren moderner Musik ist.

Weitergefasst lässt sich also sagen: Seitdem diese musikalischen Gerätschaften ihren Eintrag ins Lexikon gefunden haben, wird ein tiefer reichendes Verständnis für Sound und Technologie auch für eine wesentlich größere Zahl von Musikern relevant und nicht mehr nur für die technische Elite.

Obwohl der Fokus der Musiklehre eindeutig auf Melodie, Harmonie und Rhythmus liegt, erlangt das Element der Form, als frei manipulierbare Größe, innerhalb der Konversation einen immer höheren Stellenwert. Die westliche Musik tradiert auf Melodie und Harmonie, afrikanische und karibische auf Rhythmus. Die DJ-Kultur und die Musik unserer Zeit hingegen befassen sich mit der Form. Komponisten schaffen traditionell Musik, die den Zuhörer leitet. Ein DJ baut seine Musik eher auf die Reaktionen des Publikums auf. Das ist in der Tat nicht ganz leicht zu vermitteln, aber es ist ein bedeutender Teil moderner Musik.

Eigene Instrumente zu bauen, scheint ein wichtiger Faktor für die Entwicklung selbstbestimmten Denkens beim Komponieren und Performen zu sein. Wie führen Sie durch den Unterricht und welche Ergebnisse bringt er hervor?

Um eins festzuhalten; die Sachen, die ich zu sehen bekomme, haben nicht unbedingt etwas mit dem Kern der Ausbildung am Berklee zu tun. Was das Entwickeln von Instrumenten anbelangt, so haben wir hier die Komponenten Sound Design und interaktive Performance. Im Sound Design geht es um musikalische Funktionalität, also wie wirkt ein bestimmter Sound in einem Arrangement. Dabei kann es sich um traditionell Dinge wie Melodie, Bass oder begleitende Funktionen drehen. Oder ganz einfache abstrakte Sachen, etwa ein Sound, der seine Klangfarbe in den verschiedenen rhythmischen Abschnitten ändert.

Unsere Abteilung 'Electronic Production Design' startete schon vor 30 Jahren als Music Synthesis Department. Es war wohl das erste Programm, mit dem man einen Abschluss in Bezug auf Synthesizer machen konnte. Wir waren schon immer der Meinung, dass das Entwerfen eines Synthesizer-Patches dem Bau eines Instrumentes gleichkommt. In gewisser Weise bewegte sich das zwar auf einem kleineren Level. Aber heute, mit dem Laptop, entwirft man das gesamte Ensemble. Es ist viel mehr als die Kontrolle über einen einzelnen Sound. Es geht um die Kontrolle der Interaktion zwischen sämtlichen Sounds auf allen Ebenen: Pitch, Timbre, Lautheit, Rhythmus.

Es geht natürlich auch um die Frage, mit welcher Absicht ein Instrument gestaltet wird. Soll es sich in unterschiedlichsten Umgebungen behaupten oder einem ganz bestimmten Zweck dienen, etwa einem ganz besonderen Stück oder Event. Mit dem Modular-Synthesizer steckt man einen Patch in der Regel für eine bestimmte Performance. Mit einem Laptop-Instrument lässt sich hingegen ein Template fertigen, das den vielfältigsten Performance-Situationen gerecht wird.

„Komponisten schaffen traditionell Musik, die den Zuhörer leitet. Ein DJ baut seine Musik eher auf die Reaktionen des Publikums auf. Das ist in der Tat nicht ganz leicht zu vermitteln, aber es ist ein bedeutender Teil moderner Musik.“

Sie sagten vorhin, dass das Klavier in Ihren Augen seinem Status als musikalische Referenz nicht mehr gerecht wird. Spüren Sie, dass Musikhochschulen darauf bereits in irgend einer Weise reagieren? Was wäre, wenn sie diesem Paradigmenwechsel nicht folgen würden? Würden sie damit riskieren, hinsichtlich ihrer Auffassung von Musik als borniert zu gelten?

Das hat viel mit der Vision jeder einzelnen Institution zu tun. In den Bildungseinrichtungen oder an den Konservatorien gibt es einen etablierten Konsens darüber, wo die Referenzpunkte einer Ausbildung liegen. Dieser Konsens mag sich entwickeln, aber das geschieht nur sehr langsam. Eine Forschungsinstitution kann neue Ideen entwickeln, aber der Schwerpunkt der Ausbildung liegt an solch einer Institution eben auf der Forschung. Es gibt viele promovierte Experten aus der Musiktechnologie, die gern einen Lehrstuhl antreten würden. Aber deren Referenzen in den Lebensläufen beschränken sich für gewöhnlich auf wissenschaftliche Arbeiten und Konferenzteilnahmen. Eine kommerzielle Veröffentlichung findet man darin eher nicht. Es gibt also eine Diskrepanz zwischen dem, was zeitgemäße Musiker tatsächlich tun, zwischen der Forschung und dem Konsens an den Schulen. Das ist allerdings eine strukturelle Herausforderung, der sich alle Berufsfelder stellen müssen. Einige sind dabei weiter als andere. In der Medizin oder Wirtschaft zum Beispiel ist das Beseitigen solcher Diskrepanzen überlebenswichtig. In der Kunstschulung scheint das bisher nicht der Fall zu sein; solange bis die Ausbildungskosten derart in die Höhe schnellen, dass sie zum Handeln gezwungen ist.

Das Berklee wurde einst mit der Idee gegründet, Musik auf der Höhe der Zeit zu unterrichten. Auf die Praxis bezogen ist das aber leichter gesagt als getan. Es hat ungefähr 25 Jahre gedauert, bis wir den E-Bass als Hauptinstrument anerkannt haben. Am Juilliard und vielen anderen Konservatorien ist das bis heute nicht der Fall. Ebenfalls 25 Jahre brauchte es, um einen Kurs fürs Auflegen anbieten zu können. So gesehen zieht es sich vielleicht bis 2025, ehe wir den Laptop oder andere mobile Geräte auf gewisse Weise anerkennen. Aber wir wollen natürlich, dass es schneller geht.

Die Problemstellungen und die damit einhergehenden Gesprächsrunden sind ein aktiver Beitrag dazu, wie wir 'Electronic Production Design' zeitgemäß definieren wollen. Und wir möchten darüber informieren, wie wir uns die Ausbildung der Studenten künftig vorstellen. Das sind wirklich große Themen.

Erfahren Sie mehr über das Electronic Production and Design Department am Berklee.