Junichi Oguro: 3D-Sounds und Produzieren mit Visuals

In den letzten Jahren haben sich Mehrkanal-Surround-Soundsysteme immer mehr durchgesetzt. Das Spektrum reicht von standardisierten 5.1-Kanal-Heimkinosystemen bis zu maßgeschneiderten Surround-Lösungen für Planetarien, Museen und Konzertorte. Und der Boom ist noch lange nicht vorbei, denn 3D-Soundsysteme lassen noch viele spannende Entwicklungen in diesem Bereich erwarten: Die akustische Umgebung der nahen Zukunft besteht jedenfalls aus einer Vielzahl von Lautsprechern.

Ein 3D-Soundsystem reproduziert nicht nur bestehende akustische Umgebungen, sondern ermöglicht auch surreale musikalische Erfahrungen in einem immersiven, mit Visuals geschaffenen Raum – sein Potenzial, die Grenzen von Ausdruck und Klang zu verschieben, sind enorm. Aber was genau ist das 3D-Soundsystem? Was hat es zu bieten, wenn darüber Musik gemacht und mit einer Kaskade visueller Informationen gearbeitet wird? Was sind die Unterschiede zum traditionellen Musikmachen auf Stereolautsprechern?

Um Antworten auf diese Fragen zu bekommen, haben wir den Komponisten, Klangarchitekten und Produzenten Junichi Oguro interviewt. Surround-Projekte sind sein Spezialgebiet – von der Gestaltung eines Klangraums für ein Planetarium mit dem 43.4-Kanal-3D-Soundsystem Klangdom des ZKM bis hin zu einer Auftragskomposition für adidas im Rahmen von Olympia 2008 in Peking. Der in Sapporo ansässige zertifizierte Ableton-Experte hält Vorlesungen an einer Universität und ist auch als Musiker aktiv – Oguros neue Ambient-Single wird demnächst auf dem eigenen Label 43d erscheinen.

Wie in der neuesten One Thing-Episode zu sehen ist, lässt er sich beim Musikmachen von Videos inspirieren – eine Herangehensweise, auf die er auch im Interview eingeht. Dort spricht er darüber, wie er visuelle Infos als grafische Notation nutzt, wie sich seine Interpretation von Sounds verändert hat und über die Hörerfahrung im Allgemeinen.

Du hast als Klangarchitekt das erste 43.4-Kanal 3D-Soundsystem Japans installiert – in einem Planetarium. Wo hast du das Soundsystem kennengelernt?

Seit 2000 produziere ich vier- und achtkanalige Field-Recording-Stücke für eigene Projekte, zum Beispiel für Harmonia – eine Klanginstallation von 2012, die aus vier superdirektionalen Lautsprechern bestand. Damals hatte ich schon vom Klangdom des ZKM gehört, erlebt habe ich ihn aber erst zehn Jahre später. Damals war ich in Belfast/Nordirland, um herauszufinden, welche Technologien in Japan für einen breiten Einsatz des 3D-Soundsystems erforderlich sein würden. An der Belfaster Uni gab es in der Forschungseinrichtung SARC ein 3D-Soundsystem namens Sonic Laboratory – die Basis des derzeitigen 43.4-Kanal-Soundsystems. Als Konika Minolta 2017 die Entscheidung traf, in ihrem Planetarium in Tokio ein neues Soundsystem zu installieren, dachte ich, dass das 43.4-Kanal-Soundsystem ideal wäre – es würde gut mit Visuals funktionieren und in der Kuppel des Planetariums den Content der nächsten Generation erzeugen. Später arbeitete ich am ZKM an einem Projekt zur Einführung des Soundsystems in Japan und wurde als Klangarchitekt für das Planetarium beauftragt. Vor Kurzem habe ich ein Programm (Webseite nur auf Japanisch) geleitet und mit dem 43.4-Kanal 3D-Soundsystem Musik für das Planetarium komponiert.

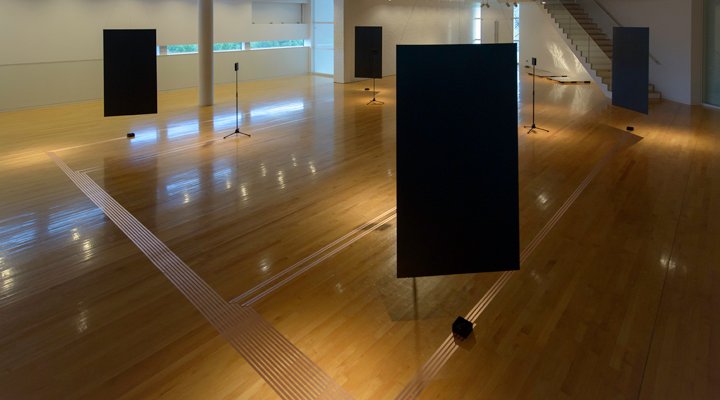

Harmonia: Junichi Oguros Klanginstallation von 2012

Kannst du uns kurz erklären, wie das 43.4-Kanal-Soundsystem funktioniert?

Es besteht aus Hardware, die ein architektonisches Akustikdesign ist – zum Beispiel Lautsprecher – und einer Software, die es ermöglicht, über die 43.4 Kanäle Sounds abzuspielen. Mit dem Soundsystem im Planetarium kann ein akustischer Raum nachgebildet werden – mittels Vector Base Amplitude Panning und Ambisonics, einem immersiven 3D-Audioformat. Das VBAP nutzt ein Dreieck aus Lautsprechern, das mit einer Anordnung von Vektoren 3D-Klänge erzeugt. Damit man mehrere Lautsprecherdreiecke so aufstellen kann, dass sie die Kuppel optimal umgeben, sind 43 separate Einheiten erforderlich. Ein Lautsprecher an der Spitze der Kuppel dient als Ausgangspunkt, von dem aus 14 Schichten von Lautsprecherdreiecken gleichmäßig entlang der Konturen der Kuppel angeordnet werden.

Wie hast du dir das Wissen über diese Technik angeeignet?

Zu einer Mehrkanalproduktion gehört sowohl die Vorbereitung von Hardware-Tools als auch die Programmierung einer eigenen Software. Ich habe schon oft Applikationen für Mehrkanal-Audio mit Max/Msp entwickelt und für eigene Produktionen verwendet. Europäische Klangforschungsinstitute wie das IRCAM und ZKM waren in diesem Bereich führend, und ich habe mich ausgiebig mit Dokumentationen von Projekten befasst, die an diesen Orten stattgefunden haben. In der Realisierungsphase einer solchen Installation arbeitet man als Team – zusammen mit Experten aus verschiedenen Bereichen, deren Techniken man dann miteinander verbinden muss. Von diesen Leuten habe ich das aktuellste Know-How gelernt.

Das Wichtigste am 3D-Soundsystem: Es macht keinen Sinn, nur die Hardware zu haben. Man muss sich auch überlegen, welche Art von Musik und Content mit diesem System kreiert werden kann. Ich habe mal für eine japanische Firma gearbeitet, die akustische Messgeräte herstellt. Dort war mein Bereich die Bauakustik: akustische Echos, Impulse und reflexionsarme Räume. So konnte ich mein Wissen auf komplexe Weise vertiefen. Als Komponist habe ich mich mit der musikalischen Seite auseinandergesetzt, und als Klangarchitekt mit den Aspekten der Akustik.

Wie hat deine Arbeit mit dem 3D-Soundsystem und Mehrkanal-Umgebungen deine Musik beeinflusst?

Mir ist die ganze Tonalität bewusster geworden. Für mich ist das Erzeugen eines Stereobilds die Grundlage für Mehrkanal-Produktionen. Es ist mir wichtig, dass das Musikstück auch stereo funktioniert, bevor ich mir dann über seine Veränderungen und Texturen im 3D-Raum Gedanken mache. Mehrkanal-Umgebungen haben einen ähnlichen Charakter wie Präzisionsmaschinen. Wie der Raum dann klingt, hängt vor allem von der Phantasie des Komponisten ab. Ich für meinen Teil habe immer ein offenes Ohr für die Klänge alltäglicher Orten oder von Field Recordings und nutze diese Hörerfahrungen dann für meine Produktionen. Ich denke, dass ich viel bewusster höre als früher.

Bei Stereoproduktionen sorgen Reverb und Delay oft für Raumtiefe. Wie erzielst du diese Tiefe mit einem 3D-Soundsystem? Gibt es eine Technik, die dafür typisch ist?

Bei einem 3D-Soundsystem werden Sounds als Objekte in einem Raum behandelt. Anders als beim flächigen Ausdruck von Klangtiefe mit zwei Kanälen repräsentieren die Positionen dieser Objekte die Positionen der Objekte selbst. Man kann die Klangtiefe zum Beispiel dadurch ausdrücken, dass man die Position weit hinten im kompletten 3D-Raum festlegt. Aber es ist auch möglich, das mit Reverb und Delay zu erreichen, genau wie mit zwei Kanälen. Ich denke, die Bedeutung der kompletten Tonalität bleibt gleich – egal ob es ein Stereo- oder 3D-Soundsystem ist.

Der größte Vorteil eines 3D-Soundsystems besteht darin, dass es die bestehenden Hörkonventionen stark verändern kann. Traditionell werden die L- und R-Kanäle überall dort festgelegt, wo sich der Hörpunkt bewegt. Das 3D-Soundsystem kann dagegen die vorderen, hinteren, linken, rechten, oberen und die unteren Kanäle frei definieren und auch einen kosmischen Raum erzeugen. Ich mache auch Field Recordings und bilde mit dem System die akustische Umgebung, die ich zum Beispiel im Dschungel höre, nach. Oder ich erschaffe einen ganz anderen Hörraum. Genau dieses neue Hörerlebnis wird meiner Meinung nach zu ganz neuen Formen des klanglichen Ausdrucks führen. Im Vergleich zum Sound in einem Virtual-Reality-Raum bietet das 3D-Soundsystem eine enorme Ausdrucksfähigkeit beim Nachbilden von Räumen. Als Soundsystem einer kommenden Ära der 3D-Visuals und immersiven Räume bietet es auch ein großes Potenzial für visuelle Kreationen oder Unterhaltungskultur – zum Beispiel Theaterstücke.

Andererseits sind binaurale Aufnahmen eine sehr interessante 3D-Soundtechnik für zwei Kanäle. Die Technik hat zwar Beschränkungen und man muss Kopfhörer verwenden, aber das Aufnehmen von Räumen mit binauralen Kunstkopf-Mikros wird sich in Zukunft bestimmt in mehr Bereichen durchsetzen.

Wie produzierst du 3D-Musikstücke?

Meistens komponiere ich zuerst Musik in einer DAW wie Ableton Live. Den digitalen 3D-Raum und die Bewegung aller Sounds erzeuge ich dann mit einer speziellen Software. Die Herausforderung besteht darin, dass man beim Komponieren bereits eine Vorstellung der Bewegung haben muss. Die Musik drückt die Entwicklung des Klangs über die Zeitachse aus. Der 3D-Raum fügt einen weiteren Parameter hinzu, der die Position des Klangs darstellt und die Breite des Ausdrucks stark erweitert. Und deswegen dauert das Produzieren natürlich länger. Mit den derzeit verfügbaren DAWs ist es aber sehr aufwendig, 100 oder 300 Kanäle für das 3D-Soundsystem zwischen den Plattformen auszutauschen und einzeln zu exportieren. Also suche ich nach eigenen Wegen und baue eine spezielles Hardware-Setup auf, mit dem sich die Daten zwischen MADIs (Multichannel Audio Digital Interfaces) übertragen lassen.

In deinem One Thing-Beitrag zeigst du, wie du durch das Synchronisieren mit Visuals Musik machst. Das ist für dich auch naheliegend, weil du schon Musik für TV-Werbungen produziert hast, die zum Bildmaterial passt.

Diese Methode habe ich beim Komponieren von Musik für das adidas-Projekt anlässlich Olympia 2008 in Peking entwickelt. Damals hatte ich anfangs nur ein Storyboard als Vorlage für meine Komposition. Sie hat sich dann weiterentwickelt, als ich die 3D-Computergrafiken bekam und die Musik an den Film angepasst habe. Am Ende wurde ein eindrucksvolles Video daraus. Und auch die Musik hatte sich nochmals weiterentwickelt – deswegen habe ich diese Arbeitsweise weiterverfolgt. Sie ist seitdem ein wesentlicher Bestandteil meines musikalischen Schaffens. Mit der aktuellen Live-Version lassen sich Filmdateien auf der Zeitachse als Videoclips bearbeiten und genau wie Audioclips schneiden – eine essenzielle Funktion beim Musikmachen auf Basis von Bildmaterial. Die Möglichkeit, das Bildmaterial frei auf der Zeitachse anzuordnen, gibt mir beim Komponieren zusätzliche Flexibilität. In meinem One Thing-Beitrag zeige ich, was alles möglich ist, wenn man Videos auf die Zeitachse setzt und als eine Art grafische Notation nutzt.

Gibt es eine Technik oder eine bestimmte Anwendung, die du bei dieser Art des Komponierens besonders nützlich findest?

Eine Anwendung zur Filmbearbeitung – DaVinci Resolve von Blackmagic. Ich nutze sie zum Schneiden von Bildmaterial und zur Farbanpassung. Ich habe die Vollversion, aber auch mit der kostenlosen Version kann man viel machen. Filme lassen sich damit wie beim Musikmachen bearbeiten – ganz ähnlich wie beim Arrangieren in Live. Ich bin mir sicher, dass immer mehr Musiker auf diese Weise audiovisuelle Stücke produzieren werden.

Im One Thing-Video nutzt du hochwertiges Kameraequipment. Aber was machst du, wenn du unterwegs spontan etwas filmen willst? Nutzt du dann dein Smartphone?

Ich habe meist ein portables Aufnahmegerät für Field Recordings und eine SLR-Kamera mit Film-Option dabei. Aber wenn nicht, dann filme ich mit meinem Smartphone. Smartphones liefern inzwischen eine genauso hohe Qualität wie kaum veraltete Vorgängermodelle von Kameras, die in der Filmindustrie verwendet werden. Und ich achte beim Filmen natürlich auf den Blickwinkel und die Auflösung. In meinem Kurs an der Uni lasse ich meine Studenten mit ihren Smartphones Videos drehen und genau so Musik machen wie in meinem One Thing-Video. Hier (nur in Japanisch) erkläre ich, wie das gemacht wird. Ich stelle auch ein kostenloses Live-Projekt zur Verfügung, das die Videoclips aus diesem Tutorial enthält.

Holen Sie sich Junichi Oguros kostenloses Live-Projekt und machen Sie Musik auf Basis von Videoclips

*Erfordert Live 10.1 Suite und neuer

Die Bewegungen, die in einem Video zu sehen sind, liefern viel Inspiration für Melodien und Rhythmen – ähnlich wie bei grafischer Notation. Besonders inspirierend ist die Art, wie sich Menschen bewegen. Ganz egal ob moderner Tanz oder die Gesten des Alltags – alle visuellen Informationen liefern Ideen für das Komponieren. Unsere Hörgewohnheiten ändern sich gerade radikal und es gibt immer mehr Menschen, die Musik über YouTube und Instagram konsumieren. Sobald es möglich wird, Drittanbieter-Videos solcher Plattformen zum Umsetzen von Ideen in audiovisuellen Produktionen zu nutzen, werden sich auch die Wege des Musikmachens und des Hörens weiter entwickeln.

Erfahren Sie auf seiner Website, Facebook und Twitter immer das Neueste über Junichi Oguro.