Julien Bayle: Unschärfe, Fragilität, Max und Live

Technik entwickelt sich weiter und mediale Ästhetik scheint bald keine Grenzen mehr zu kennen. Moderne Computer, Controller und leistungsstarke Tools wie Ableton Live, Push und Max: Mit diesen Werkzeugen komponiert Julien Bayle Musik, erschafft Visuals und performt beides. Wenn er gerade mal nicht als Ableton Certified Trainer oder als Buchautor in Sachen Musik und Programmierung beschäftigt ist. Julien hat vor kurzem einige Projekte abgeschlossen (und schon wieder neue begonnen) und fand trotzdem Zeit für ein Interview. Wir sprachen mit ihm über die audio-visuelle Performance und fragten ihn, was ihn ursprünglich zu Live brachte. Außerdem bekamen wir von ihm wertvolle Tipps für Live-Einsteiger wie erfahrene Anwender.

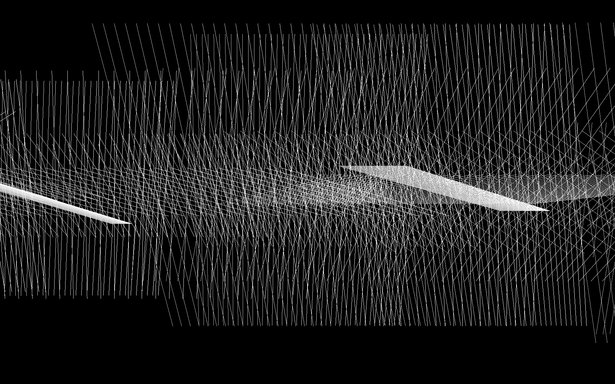

Some of Julien’s visual work.

Viele deiner Arbeiten sind minimalistisch hinsichtlich Sound und Design. Wie entwickelst du deine Sounds?

Ich habe viele verschiedene Methoden - fast alle sind digital, weil ich Max 6 nutze. Ich verwende auch oft Reaktor. Dann steuere ich alles in Echtzeit an. Auf der Bühne nutze ich eigentlich wenige Samples – es sind fast immer Sequenzer, die synthetische Sounds triggern. Ich will Kontrolle über jeden Aspekt meines Live-Sets haben – von der Sequenz bis zum Sound. In vielen Fällen nutze ich modifizierte Reaktor-Sequenzer und entwickle auch eigene Sequenzer, natürlich mit Max for Live.

Ich mag die grundlegenden Konzepte von Synthese – granular, additiv, subtraktiv, Wavetable – und meine Sounds sollen sehr minimal sein. Aus meiner Sicht ist das mit komplexen generativen Prozessen nur bedingt möglich.

Ich nutze auch gerne Algorithmen, um Sounds entstehen zu lassen. Oft beginne ich mit einer Sequenz und programmiere mehr oder wenige deterministische Algorithmen, um sie weiterzuentwickeln. Beispielsweise steuere ich ein Filter durch einen sich entfaltenden Algorithmus, statt mit einem LFO oder per Hand. Das Ergebnis klingt jedesmal merkwürdig, egal ob es synchronisiert ist oder nicht [lacht].

Wie lässt du deine Visuals mit deinen Sounds interagieren?

Ich habe Sounds und Visuals immer als zwei Seiten derselben kreativen Angelegenheit betrachtet. Eigentlich ist das ähnlich wie Synästhesie, auch wenn ich physiologisch gesehen kein Synästhetiker bin. Ich nehme Luftbewegungen als Farben und Klangfrequenzen als Helligkeitswerte wahr. Ohne ein passendes visuelles Artwork kann ich mir meine Musik / meinen Sound nicht vorstellen.

Meine Zusammenarbeit mit dem Mechanic & Acoustic Laboratory of CNRS (Französisches Forschungsinstitut) gab mir vor kurzem die Möglichkeit, meine klanganalytischen Konzepte zu verbessern. Patrick Sanchez, der Forschungsingenieur und Soundexperte, half mir mit seinem ganzen Fachwissen bei der Optimierung meiner Analyse-Patches und -Tools.

Julien’s waveform-based visuals.

Ich lege die Amplitude/Hüllkurve von Audiokanälen oft in Matrizen. Das ist ein guter Weg, Wellenform-Diagramme zu entwickeln, mit denen ich dann spielen kann, indem ich das Signal downsample und die grafischen Punkte zum Bewegen anderer Parameter verwende.

Neben der Audio-Analyse verwende ich oft auch die MIDI-Daten meiner Sequenzer für Live-Visuals. Sequenzer sind enorme Datenquellen und sie brauchen oft viel weniger CPU-Power als die reine Echtzeit-Soundanalyse.

Ein Beispiel: Ich triggere einen langen Pad-Sound. Sobald er gestartet wird (z.B. durch einen MIDI-Note-on-Befehl eines Clips in meinem Live-Set), wird das MIDI-Instrument angesteuert und produziert einen Sound. Gleichzeitig fange ich den Befehl in einer zusätzlichen Spur ein und route ihn aus Live zu Max, wo er einen Film ansteuert, oder eine Bewegung in meiner openGL-basierten Szene startet. Sobald der lange Pad-Sound aufhört, wird ein MIDI-Note-off-Befehl gesendet und vom Max-6-System empfangen. Das beendet die Wiedergabe des Films oder stoppt die Bewegung. Dies ist ein weiterer Weg, MIDI zu verwenden und Visuals mit synchronisierten Audio-Signalen zu triggern und zu modulieren.

Excerpt from a live performance of “Disrupt!on”

Worum geht es bei deinem Projekt „Disrupt!on“?

Das Projekt befasst sich mit Signalunterbrechungen und -störungen und wurde von François Larini für das Nouveau Musée National de Monaco kuratiert. „Disrupt!on“ ist auch der Name einer damit verbundenen Installation, die ich im März und April in The Centre of Attention in London gezeigt habe.

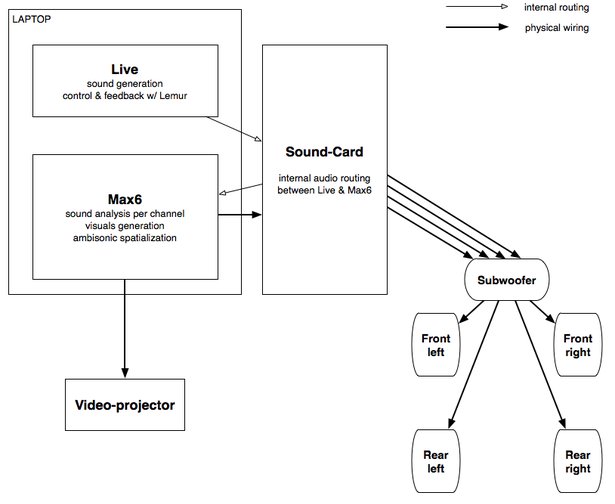

Die experimentelle Musik für das Museum in Monaco habe ich zusammen mit Visuals entwickelt. In dieser Performance kamen vier Audio-Kanäle und ein Subwoofer zur Anwendung – ein Genelec-System, das die Frequenzen direkt im Subwoofer aufspaltete. Dabei war es notwendig, die Kanäle korrekt vom Set aus anzusteuern. Ich wählte dafür eine sehr einfache Routing-Methode, hier dargestellt als Schema:

Schematic for routing in “Disrupt!on”

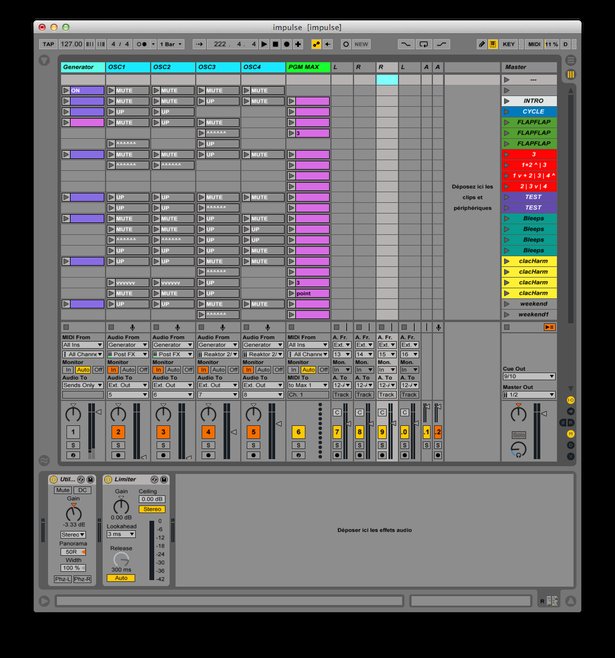

Live steuert hier die gesamte Klangerzeugung. Ich verwende vier Spuren – für jeden Kanal eine. Durch Source-Routing greife ich alle vier Kanäle meines Reaktor-basierten Patchs ab. Die Kanäle sind separat mit Mono-Eingängen meiner Soundkarte verbunden, mit internen Routing- und Loopback-Möglichkeiten (zur Zeit nutze ich die RME Fireface UC). Durch die Mixing-Software TotalMix kann ich die Kanäle einfach zu meinem Max-Patch routen. Dieses virtuelle Routing wird vom Audio-Interface gesteuert, um den Laptop-Prozessor zu entlasten.

Julien’s Live Set for “Disrupt!on”

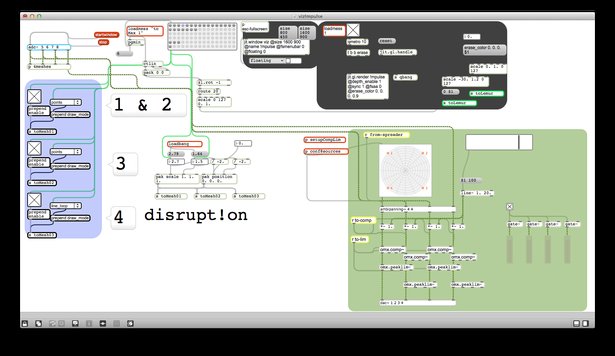

Für die Erzeugung der Visuals analysiert mein Max-Patch die einzelnen Audio-Kanäle der Soundkarte. Im Grunde zeichne ich jede Hüllkurve (und manchmal Frequenzbänder) auf ein X/Y-Diagramm. Wie viele andere meiner Arbeiten ist die „Disrupt!on“-Installation sehr minimalistisch, auch in Hinsicht auf das Design.

Julien’s Max patch for “Disrupt!on”

Ich nutze Ambisonic Externals vom Institute for Computer Music and Sound Technology. Damit kann ich meine vier Kanäle leicht abgreifen und gemäß der Platzierung der Lautsprecher sowie anderer Parameter, die sich live steuern lassen, zuordnen. Bei Disrupt!on habe ich eine ungewöhnliche Art der räumlichen Zuordnung angewendet: Die Visualisierung der Sounds selbst. Das muss ich noch etwas genauer erklären, weil es ein zentraler Aspekt des Projekts ist.

Ich erzeuge vier Audio-Signale und platziere sie auf dem Bildschirm, gemäß spezifischer visueller Regeln, die ich während der Performance ändern kann. Dann werden die verschiedenen Positionen der gezeichneten Figuren wieder in das System eingeführt, um den Sound selbst räumlich zuzuordnen. Das sorgt für mehr Fragilität und Unschärfe, und genau mit diesen Elementen will ich spielen. Es gibt also eine direkte Korrespondenz zwischen den Visuals auf dem Bildschirm und der Positionierung der Sounds im Raum.

Dein Blog zu lesen ist immer wieder inspirierend. Neulich hast du über ein „wirklich seltsames“ Experiment in einem schalltoten Raum geschrieben. Wie hast du als Klangkünstler die vollständige Abwesenheit von Klang empfunden?

Was mich besonders beeindruckt hat, war der fehlende Nachhall meiner eigenen Geräusche. Als ich in dem Raum war, hatte ich gleich den Drang zu sprechen – einerseits aus Neugier, aber vielleicht auch um mir Mut zu machen. Ich war sehr fasziniert von der Wirkung (besser gesagt von der fehlenden Wirkung) meiner eigenen Geräusche auf die Umgebung.

Ryoji Ikedas Installation db wurde für einen schalltoten Raum entwickelt (und beinhaltete auch einen Panic-Button). Ich würde in dieser akustischen Situation sehr gerne weiterexperimentieren und auch eine Installation entwickeln – inklusive Licht, also mehr als nur von einem Beamer projizierte Visuals. Das könnte auch ein guter Start für meine mögliche Zusammenarbeit mit Philips Lighting sein – ich habe sie vor kurzem gefragt, ob sie Interesse daran hätten.

Wenn du Live-Anwendern nur einen einzigen Tipp geben könntest, welcher würde es sein?

Hier ist ein ganz einfacher, doch sehr wirkungsvoller Move:

- Ein Sample in eine Audio-Spur ziehen. Live wird einen Audio-Clip erzeugen.

- Die Option „Auf neue MIDI-Spur slicen“ per Rechtsklick über dem Clip wählen. Live wird jetzt eine neue MIDI-Spur erzeugen und einen Clip, der ein Drum Rack triggert, in dem die Sample-Slices bereits angelegt sind.

- Dann den Random MIDI-Effekt vor das Drum Rack legen und den „Chance“-Parameter ändern. Dies wird die Wiedergabe des zerlegten Samples komplett dekonstruieren – die Reihenfolge der Slices wird vertauscht und es wird ziemlich „glitchy“. Wenn man den MIDI-Effekt Scale hinter Random legt, wird der Zufallsmodus etwas kanalisiert – die Random-Modulation geschieht nun innerhalb eines festgelegten Rahmens. Dahinter würde ich noch Beat Repeat setzen – die Triolen am besten mit „No Triplets“ entfernen – und die Parameter „Grid“ und „Offset“ modulieren.

Diese grundlegenden Elemente können viele Ideen für die Beat-Manipulation und Variationen liefern – ausgehend von einem einzigen Sample. Und alles ist komplett nicht-destruktiv – ein weiteres Beispiel dafür, was sich mit MIDI alles anstellen lässt, selbst wenn ein Audio-Sample am Beginn des Vorgangs steht.

Julien performs with Live and Push

Welche anderen Künstler inspirieren deine Musik und deine Visuals?

Ich höre viel Musik von Autechre und dem Label Raster-Noton, Lustmord und Geir Janssen [Biosphere]. Ihre deepen Ambient-Tracks sind sehr interessant, wenn ich komplexe Strukturen programmiere. Manchmal höre ich dabei auch total chaotische IDM-Tracks. Das hört sich vielleicht merkwürdig an, weil es kaum entspannend ist, doch ich brauche das oft in diesen Momenten.

Was mich auch stark interessiert sind die Arbeiten und Konzepte von Architekten und Designern. Vielleicht ist das neben anderen Musikern die größte Inspirationsquelle für meine eigenen Kreationen.

Carsten Nicolai (alias Alva Noto) ist ein Künstler, dessen Werke ich wirklich gerne lese, höre und ansehe. Im Musikbereich kennen ihn nur wenige Leute als Bildhauer, Designer oder Architekt, und in diesen anderen Bereichen wissen nur wenige, dass er ein experimenteller elektronischer Musiker ist. Ich schlage ja selbst gerne Brücken zwischen unterschiedlichen Genres und Kontexten und deshalb gefällt es mir sehr, wie Nicolai seinen eigenen kreativen Weg geht.