Jonathan Zorn: Die unheimliche Stimme

Im Studio von Jonathan Zorn - Foto: Ross McDermott

Schon seit geraumer Zeit gibt es Musiker, die sich mit der vermeintlichen Unvollkommenheit von Dingen beschäftigen, derer habhaft werden und sie darüber hinaus sogar noch verstärken. Man braucht nur allein auf die Vielzahl von Plug-Ins zu schauen, mit denen sich die charakteristischen Verzerrungen von Röhrenschaltkreisen, Vinylplatten und Analogbändern replizieren lassen. Und in wie vielen modernen Produktionen stößt man heute nicht zuletzt auf gesampeltes Knistern und Bandrauschen.

In dieser Tradition steht auch der elektroakustische Musiker Jonathan Zorn, der mitAnd Perforation eine Reihe von Stücken zusammen getragen hat, für die Texte von Sigmund Freud wieder und wieder durch den Googleübersetzer liefen. Schon nach kurzer Zeit gewann die Mangelhaftigkeit des Systems die Oberhand und veränderte den Sinn der rezitierten Worte.

And Perforation von Jonathan Zorn

Anlässlich der Veröffentlichungen von And Perforation und dem Geschwister-ReleaseLanguage as Dust sprachen wir mit Jonathan über seine Arbeit mit Vocodern und modularen Synthesizern, über das Sezieren von Sprache und über die Erstellung eines reaktiven Performance-Setups mit Live.

Kannst du uns zum Anfang einmal durch den Prozess der Textmontagen für Language is Dust und And Perforation führen?

Zu And Perforation: Ein Freund borgte mir seinen Doepfer Modular-Vocoder und es schien die perfekte Gelegenheit zu sein, eine Reihe von Stücken zu komponieren, die sich mit Sigmund Freuds Essay Das Unheimliche befassten. Die Idee, das etwas zur selben Zeit gleichermaßen vertraut und fremdartig sein kann, erschien mir derart passend, um meine Faszination für synthetische Stimmen zu beschreiben.

Für die Textkreation nutzte ich erst einmal Google zur Übersetzung des originalen deutschen Textes ins Englische. „Obvious Difference Scary“ enthält eine kurze Passage, die hintereinander weg durch verschiedene Sprachen lief und dann erst zurück ins Englische kam. Man hört, wie die buchstäbliche Übersetzung von „Das Unheimliche“ zunehmend verzerrt. Für „Bizarre“ habe ich eine längere Text-Passage mit der Autozusammenfassung von Microsoft Word behandelt und danach den Googleübersetzer benutzt.

Processing Freud through Google Translate.Freud in Google Translate

Der Text für Language as Dust enthält dagegen Auszüge aus Aristoteles' De Anima, Julia Kristevas Aufsätzen zur semiotischen Theorie, Thomas Edisons Notizen zur erwartbaren Nutzung der Aufnahmetechnologie, zu missverständlicher Vocoderkommunikation aus Dave Tompkins’ Buch zur Geschichte des Vocoders undTonbandstimmen (Konstantin Raudives Transkriptionen seiner Kommunikation mit dem Jenseits via Radio-Rauschen).

Einige der Techniken zur Textmanipulation stützen sich auf die MS Word Funktion 'Autozusammenfassung', gehen auf das Aneinanderlegen von verschiedenen Text-Schnipseln zurück (nach der Schnitttechnikmethode von Burroughs), fußen auf Löschung und Übersetzung. Durch diese Prozesse entwickelte ich ein Interesse daran, Sprache als musikalisches Material nutzbar zu machen. In „Meditation on Pattern and Noise“ zum Beispiel wiederhole ich Phrasen und Wörter, um Soundpattern zu erzeugen, die einer musikalischen Logik folgen, unabhängig von der semantischen Bedeutung.

Jonathan Zorn - Language as Dust

Wie gehst du bei der Arbeit an diesen Stücken im Studio vor? Kannst du uns etwas über die Verwendung des Vocoders erzählen?

Zunächst erstellte ich Diagramme, um die Laufzeiten, Vocal-Effekte, Pitch-Sets und Texte zuzuordnen. Danach nahm ich die Texte und verschiedenste Instrumente auf – Violine, Kontrabass, Klavier, Harfe, modulare Synthesizer, DSI PolyEvolver und ein „Weltempfänger-Röhrenradio“ aus den 1930ern. Zum Schluss manipulierte ich meine Stimmaufnahmen mit SuperCollider, Max/MSP, Ableton Live und der Sprachanalyse-Software Praat.

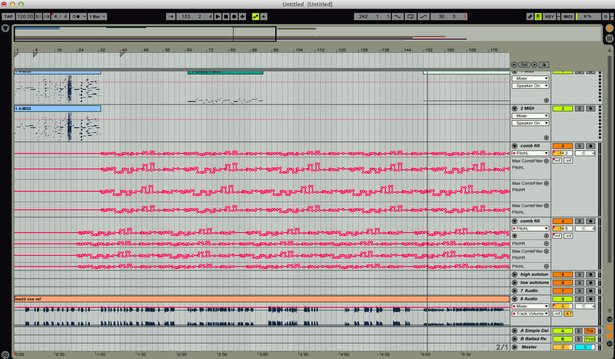

Automation in Looper bei der Entstehung von And Perforation

Die Stücke für And Perforation waren so angedacht, dass sie auch als Live-Performance funktionieren sollten. Also beschränkte ich mich auf die Arbeit mit Live und den Doepfer Modular-Vocoder. Letztlich fiel die Wahl auf Live, weil das Processing und das Routing vom und zum Vocoder so einfach ist. Vocoder funktionieren am besten unter permanenter Dynamik, also war es wichtig, vor und hinter dem Vocoder Kompression und EQs drauflegen zu können. Auch die verschiedenen Soundquellen ließen sich mit Live problemlos zu den Eingängen des Vocoders routen. Das half mir sowohl bei der Entwicklung des Sounds als auch bei der Performance. Als ich den Doepfer Vocoder seinem eigentlichen Besitzer zurück gab, konnte ich die Stücke mit dem Vocoder in Live ziemlich schnell rekonstruieren.

Wie hast du dich auf die Performance der Stücke von Language is Dust vorbereitet?

Auf eine gewisse Art war die Performance dieser Stücke trügerisch einfach. Das Automations-Setup steht bereits, ich drücke die Leertaste und fange an zu sprechen. Entscheidend ist das richtige Timing beim Vortragen des Textes und es erfordert ein hohes Maß an Konzentration, dabei entspannt zu bleiben. Ich versuche bei diesen Stücken als Person komplett in den Hintergrund zu treten. Dafür muss ich die Eigenheiten meiner Sprachkadenz komplett ausblenden.

Bei allen Stücken läuft der Mikrofon-Input durch eine simple Signalkette aus Kompression, EQ und einem Gate, bevor er auf den Vocoder oder andere Effekte trifft.

Da Language as Dust ursprünglich ein reines Studioprojekt war, habe ich es mit Live und Max for Live zurück gebaut, um daraus eine Performance-Version machen zu können. Im Moment sind die Performance-Versionen für die zweite und die dritte Sektion fertig:

Automatisierte Comb Filter aus „Meditation on Pattern and Noise“

Für „Meditation on Pattern and Noise“ nutze ich Autotune, Live und Comb Filter und Delays aus Max for Live. Nachdem ich mich für den Einsatz einer gesampelten Harfe entschied, hatte ich auch etlichen Spaß mit MIDI-Daten. Dafür nutzte ich den M4L-MIDI-Granulator, gefolgt von einem Rack mit Skalen-Effekten. So erzeugte ich für die Harfe und Autotunes eine Fülle chaotischer MIDI-Events.

Drei Instrument-Tracks und drei Synthesizer-Tracks in „Meditation on Presence and Absence“ sind bereits voraufgezeichnet. Jeder Instrument-Track füttert zwei Vocoder-Tracks. Einen, in dem meine Sprechstimme vom Instrument moduliert wird und einen, in dem es genau umgekehrt vonstatten geht. In der Performance-Version kommen vier Vocoder-Tracks und Sonic Charges Beatspeak zum Einsatz, um den LPC-Stimmensound live zu reproduzieren. Außerdem verwende ich einen Midifighter 3D. Damit kann ich meine Sammlung synthetischer Phänomene spielen. Bei beiden Stücken werden sämtliche Effektmodulationen sowie die Ausbalancierung des Mixes über eine große Anzahl von Automationen kontrolliert, die das Ganze ziemlich nah an der Studioversion halten.

Wie bringst du als elektroakustischer Musiker das Zusammenspiel von experimenteller Computermusik und traditionellen Instrumenten in Einklang?

Als Komponist beginnt mein Arbeitsprozess mit einer Kombination aus konzeptioneller Verdeutlichung und akustischem Spiel. Ich nähere mich der elektronischen Musik als Komponist und als Performer gleichermaßen. Wenn ich Kontrabass spiele, sendet die physische Präsenz des Instruments Informationen, wie ich mit den elektronischen Sounds umzugehen habe. Ich habe in etwa zeitgleich den Umgang mit elektronischen wie akustischen Instrumenten erlernt. Folglich betrachte ich meine kompositorischen Arbeiten mit elektronischen und akustischen Instrumenten nicht als fundamental anders. Jeder Bereich unterliegt natürlich gewissen Einschränkungen, die es zu beachten gilt. Aber Komponisten sind von Haus aus an bestimmte Zwänge bei der Soundproduktion gewöhnt, egal ob nun ein Mensch mit einem echten Instrument spielt oder ob es sich um eine auf dem Computer laufende Synthese-Software handelt.

Jonathan Zorn – Stück für Kontrabass und Computer.

Die geschriebenen Instrumente für Language as Dust erlauben keinerlei Improvisation und es gibt keine Möglichkeit der Spektralanalyse zur Erstellung von Daten, auf die der Computer reagieren könnte. Stattdessen durchlaufen meine Stimme und die Instrumente unter Verwendung des Vocoders und der LPC-Prozesse verschiedene Stufen der Transformation.

Letzten Endes interessiert mich am meisten das Kräfteverhältnis zwischen Klang und Konzept – eine Art Denken in Sound. Ich habe entdeckt, dass die Computertechnologie mich genau dahingehend unterstützt. Für mich stehen der tatsächliche Klang und das Konzept im Vordergrund, nicht die zur Erschaffung notwendige Technologie. Doch viele der konzeptionellen Einfälle, die ich mit meiner Arbeit entwickle, entspringen meiner Faszination für die Geschichte der Sound-Technologie und der menschlichen Beziehung zu diesen vorwiegend elektronischen Erfindungen. Das Zusammenspiel von akustischen und elektronischen Sounds hat etwas Ergreifendes, insbesondere die Kombination der menschlichen Stimme und elektronischem Sound, aus der die Furcht vor dem Augenblick zu sprechen scheint.