Live durch Visuals erweitern: Drei Künstler:innen zeigen, wie das geht

Bei einer Performance ist die visuelle Ebene manchmal genauso wichtig wie die Musik selbst. Live kann die Brücke zwischen beidem sein und Ihnen die komplette Kontrolle über das klangliche und visuelle Erlebnis verschaffen. Manche Anwender:innen kennen die vielen Möglichkeiten bereits (zum Beispiel aus früheren Artikeln und Interviews auf dem Ableton-Blog oder aus Loop-Talks). Für alle anderen wollen wir dieses Thema hier nochmal beleuchten und vor allem auf die technischen Aspekte eingehen, die das Zusammenspiel zwischen Visuals und Musik ermöglichen. Zu diesem Zweck haben wir mit drei audiovisuellen Künstler:innen gesprochen, die Live als Schaltzentrale für ihre Performance nutzen, und sie darum gebeten, eine ihrer aktuellen Arbeiten für uns zu analysieren.

Alle drei greifen bei ihren audiovisuellen Arbeiten auf bestimmte Tools und Workflows zurück, zum Beispiel Max for Live, Video-Software von Drittanbietern und die Programmierung von DMX-Lichtern in Live. Diese Lösungen unterscheiden sich in technischer Hinsicht und sollen Ihnen zeigen, wie Sie Ihre Performance um visuelle Elemente bereichern können – ganz egal ob Sie schon lange mit Live Musik machen oder gerade erst damit begonnen haben.

Sabina Covarrubias Viaje

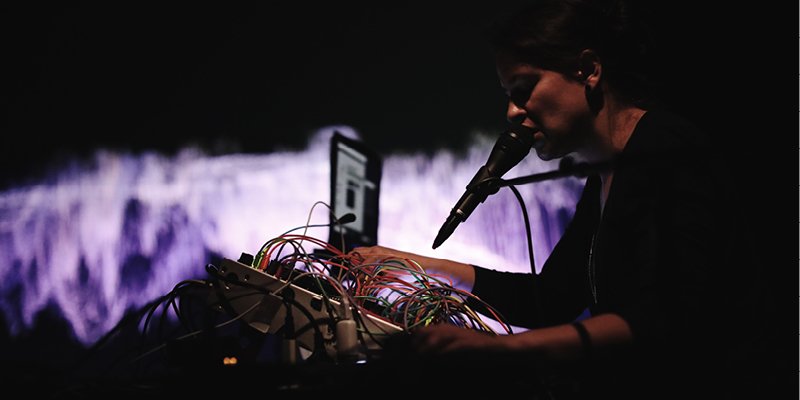

Sabina Covarrubias ist eine Komponistin und Multimedia-Künstlerin aus Mexico City, die zur Zeit in Paris lebt. Ihre audiovisuellen Arbeiten werden mit allen möglichen Attributen bedacht: visuelle Musik, elektroakustische und elektronische Musik, symphonische Musik, Chormusik, algorithmische Fotografie und auf Audio reagierende Live-Visuals. Covarrubias' neuestes Stück Viaje hat eine Länge von 42 Minuten – live gespielte elektronische Musik mit generativen Visuals. Sie nutzt dafür ihren Modularsynth, einen Vocoder und Visuals, die sie mit Jitter entwickelt hat – einer Sammlung von Max/MSP-Objekten.

Sabina Covarrubias – “Viaje”

Die praktische Anwendung von Jitter erlernte Covarrubias während ihres Doktorats im Bereich Multimedia-Partituren an der Université de Paris. Sie beschäftigte sich ausgiebig mit der visuellen Darstellung von Klängen und machte Jitter dann während ihrer Studien am IRCAM (Institute for Research and Coordination in Acoustics/Music) zu ihrem Spezialgebiet. Bei unserem Gespräch wollten wir herausfinden, wie Covarrubias mit Jitter in Max for Live die Visuals für Viaje entwickelt hat. Freundlicherweise hat sie uns auch ein Tutorial und einen kostenlosen Max for Live-Patch zur Verfügung gestellt, um Ihnen den Einstieg in die Materie zu erleichtern.

Was hat dich zu Viaje inspiriert? Und wie hast du das dann musikalisch und visuell umgesetzt?

„Viaje“ bedeutet „Reise“ – in diesem Fall bezogen auf die Reise durch die Seele, inspiriert von Ideen des Schamanismus. Meine Eltern nannten mich Sabina – nach einer gleichnamigen Schamanistin. Ich bin keine Spezialistin, aber ich weiß, dass das Reisen im Schamanismus eng mit der Erkundung der eigenen Seele verbunden ist. Bei der Komposition ging es mir darum, diese „Reise“ in mir selbst entstehen zu lassen – aber ich möchte das gar nicht programmatisch verstanden wissen. Jede:r kann sich darunter vorstellen, was er:sie will.

Das Stück besteht aus mehreren Abschnitten, die jeweils einem Teil der Reise entsprechen. In gewisser Weise geht es um die Reise vom Chaos zur Geordnetheit, und das Stück besitzt klanglich wie visuell die gleiche Struktur. Insgesamt sind es sechs verschiedene Bilder, die durch Brücken miteinander verbunden sind.

Wie hängen Musik und Bild zusammen? Und was kam zuerst? Oder hast du beides gleichzeitig entwickelt?

Beim Komponieren sind die Klänge sehr oft schon mit Bildern verbunden. Bei Viaje habe ich mich zuerst mit den Klängen befasst, konnte mir aber bereits die zugehörigen Visuals vorstellen.

Wow. Welche Art von Dingen sind das? Formen und Farben?

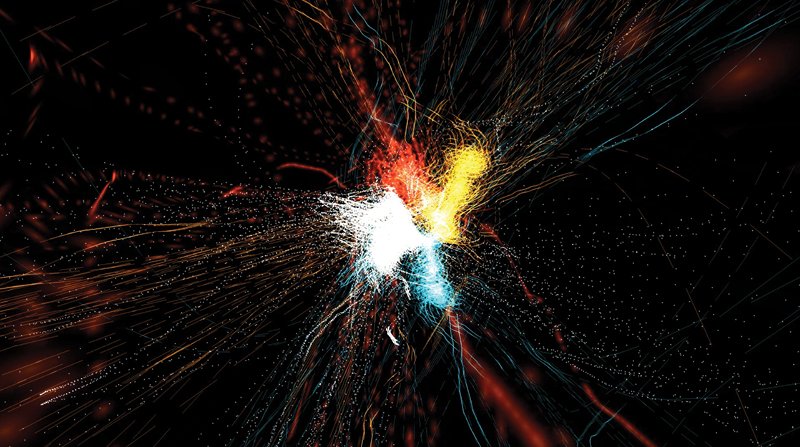

Das ist nicht so spezifisch, aber es gibt zum Beispiel einen Teil, der für mich wie ein See mit Fröschen klingt. Ich stellte mir also schon Tiere und einen Dschungel vor – etwas, das mit Natur verbunden ist. Für die Visuals habe ich einen Algorithmus namens Boids genutzt. Er bildet die Flugbewegungen von Vögeln nach und sieht wie herumfliegende Käfer oder Bienen aus.

Ein Film-Still des Abschnitts mit dem Boids-Algorithmus

Stellst du dir beim Hören von Musik immer gleich Bilder vor? Oder hat sich diese Fähigkeit erst im Lauf der Zeit entwickelt?

Ich denke, dass das automatisch passiert, aber es hat auch mit meinem musikalischen Hintergrund zu tun – und damit, dass ich Orchestrierung gelernt habe. Um die Konzepte der Orchestrierung zu verstehen, musste ich sie mir bildlich vorstellen. Als Kind habe ich den Film „Fantasia“ gesehen, und das hat mir dabei geholfen – die Klänge und Bilder waren einander so nah! Es dauerte nicht lange, bis das für mich ganz normal war – etwas zu hören, und mir das dann gleich bildlich vorzustellen.

„Fantasia“ ist ein schönes Beispiel – ich muss mir den Film unbedingt nochmal anschauen. Wie viel Improvisation steckt hinter den Klängen und Bildern von Viaje? Und hast du beim Performen eine eigene Philosophie der Improvisation?

Manche visuellen und klanglichen Teile sind vorab aufgenommen, aber sie lassen sich variieren, wenn ich mit dem Vocoder und der Percussion performe. Ganz ähnlich wie bei der Architektur eines Gebäudes – manche Teile bleiben immer gleich, weil sie die strukturellen Säulen der Arbeit sind, aber in der Mitte lassen sich andere Teile ausdehnen oder verkürzen.

Welches Setup nutzt du bei deiner Viaje-Performance für die Klänge und Visuals?

Das kommt wirklich auf die Situation der Aufführung an. Wenn ich beim Improvisieren etwas flexibler sein will, mache ich das in Live. Und wenn die klangliche Ebene schon ein Stückweit feststehen soll, nutze ich nur den Modularsynth.

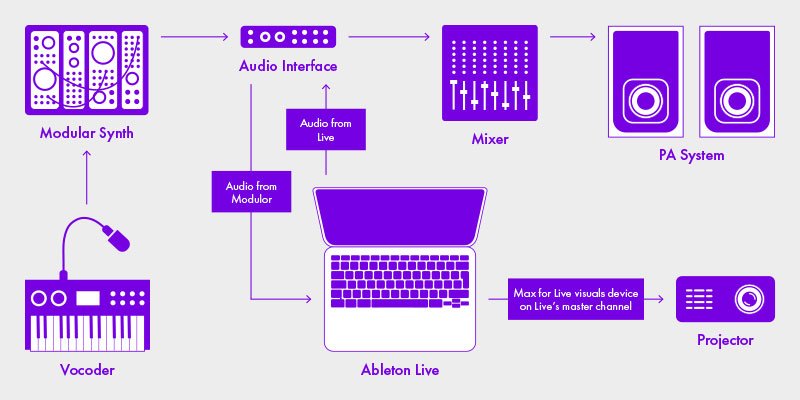

Für die zweite Variante laufen die Visuals über einen PC – einen 15-inch Alienware-Laptop mit der Grafikkarte Nvidia GTX 1070. Ich habe einen Max/MSP-Patch, der die Visuals in der Stand-alone-Version von Max live generiert (weitere Infos zu den Unterschieden zwischen Max for Live und Max/MSP finden Sie in unserer Knowledge Base). Für die Audio-Ebene nutze ich dann nur meinen Modularsynth – mit zwei Intellijel Plonk-Modulen, Mutable Instruments Plaits und einer 2HP Kick für die Percussion. Außerdem den Vocoder Roland VP-03 und Bitbox mk2 von 1010 Music, um die vorab aufgenommen Teile abzuspielen. Wenn ich auf diese Weise arbeite, sind die Visuals und Klänge voneinander getrennt.

Wenn ich bei der Performance mehr improvisieren will, nutze ich Live. Denn dann bin ich einfach viel flexibler. In dem gerade beschriebenen Setup sind die Klänge des Modularsynth bereits gemischt, aber mit Live kann ich die meisten Teile ungemischt lassen und dann zu verschiedenen Zeitpunkten triggern. Bei diesem Setup habe ich einen Computer, auf dem ich das Audiosignal durch Live laufen lasse, und der modifizierte Max-Patch läuft als Max-for-Live-Effekt, um die Visuals zu bearbeiten. Das Ausgangssignal des Modularsynths kommt in eine Eingangsspur in Live, und in derselben Spur habe ich eine Max-for-Live-Anwendung, welche die Bilder erzeugt.

Routing-Diagramm für Covarrubias' Performance-Setup

Wenn du Audio und Video mit Live bearbeitest – kommt der Prozessor dann manchmal auch an seine Grenzen? Hast du Tipps zur Minimierung der CPU-Last – bei Ableton oder Max?

Das ist ein komplexes Thema. Meine Lösung besteht darin, dass ich den Max-Patch so weitgehend wie möglich mit OpenGL-Objekten programmiere, die mit der Grafikkarte des Computers arbeiten und genügend Kapazität für den Prozessor (und die Klangbearbeitung) übrig lassen. Deswegen ist es auch sehr wichtig für mich, eine gute Grafikkarte zu haben.

Was sind deiner Meinung nach die Vorteile und Nachteile bei der Nutzung von Max for Live für die Erzeugung von Visuals – im Vergleich zu anderer Software, die auf Visuals spezialisiert ist?

Der Vorteil von Max/MSP in Live ist das gebündelte Potenzial beider Programme. Max besitzt Objekte, die für die Klang- und MIDI-Analyse ausgelegt sind – man kann also im Handumdrehen zu interessanten Ergebnissen gelangen, ohne viel über die Programmierung zu wissen.

Du kannst dir Live als das Gehirn vorstellen, das Informationen an deine Synthesizer schickt, um sie zu steuern – und sie gleichzeitig via Max for Live auch für die Visuals verfügbar macht: Alles passiert in derselben Software. Ich kann mir aus Live alle Informationen holen und dann mit Max for Live bearbeiten.

Ich weiß, dass du viel Erfahrung damit hast, anderen Leuten dein Wissen über Visuals mit Max und Jitter zu vermitteln. Hast du allgemeine Tipps für Musiker:innen, die Ableton Live nutzen und in diesen Bereich einsteigen wollen?

Am besten steigt man Schritt für Schritt in die Welt von Max for Live ein – und versucht dann, Jitter zu verstehen. Auf meiner Webseite habe ich eine Liste von Lernressourcen zur Entwicklung von Max for Live-Anwendungen mit Jitter und OpenGL zusammengestellt. Das empfehle ich als Startpunkt. Als Nächstes solltet ihr Jitter lernen, und beim Programmieren von Visuals in Ableton Live via Max for Live immer globobjects nutzen – das schont nämlich den Prozessor!

Jess Jacobs und Pussy Riot

Jess Jacobs arbeitet als Musiktechnologie-Spezialistin und Mix-Engineer in Los Angeles. Sie komponiert, performt und produziert mit mehreren Instrumenten – und vermischt diese Kategorien mit Freude. Bevor all ihre Auftritte für das Jahr 2020 abgesagt wurden, hatte sie eine Zusammenarbeit mit der russischen Punkband und dem feministischen Performance-Kollektiv Pussy Riot gestartet. Bei unserem Gespräch bekamen wir einen spannenden Einblick in die vielen Rollen, die Jess bei ihrer künstlerischen Arbeit einnimmt – erweitert durch die Perspektive des Pussy Riot-Mitglieds Nadya Tolokonnikova, die für die kreative Vision der Gruppe zuständig ist. Die beiden erzählten uns, wie sie zusammen die Visuals für ihre anstehende Tour entwickelt haben.

Nadya, was ist das Konzept für die kommenden Pussy Riot-Performances? Und wie willst du deine Ideen auf der Bühne umsetzen?

Nadya: Der Schwerpunkt der Performance liegt definitiv auf den Visuals. Die Musik ist natürlich auch wichtig, aber für mich und die anderen Pussy Riot-Mitgliederinnen war die visuelle Seite immer gleichrangig. Manchmal bezeichnen wir das sogar als audiovisuelle Performance und weniger als traditionelles Musikkonzert.

Wie wird die visuelle Ebene festgelegt? Und woher stammt das Ausgangsmaterial für die Projektion?

Nadya: Je nachdem – aber meistens stammt das Material nicht aus dem Internet. Falls doch, dann bitten wir um Erlaubnis. Das meiste Material haben wir selbst gefilmt, mit mir als Regisseurin und Kamerafrau. Manchmal übernimmt auch jemand anders die Kamera. Zusätzlich kümmere ich mich um die Bearbeitung und Farbkorrekturen. Bei den meisten Videos mache ich das alleine, in 30 % der Fälle arbeite ich mit visuellen Künstler:innen aus aller Welt zusammen – aus Argentinien, Russland und sogar abgelegenen Orten in Sibirien.

Wie hast du Jess deine ästhetische Vision vermittelt? Und wie sah eure Zusammenarbeit aus?

Nadya: Es war unglaublich! Ich sagte: „Wir müssen dies oder jenes machen“, und Jess meinte nur: „OK – und so wird das dann umgesetzt“. Ich hätte nie gedacht, dass wir eine Person finden, die Video, Licht und Musik gleichzeitig steuern kann. Denn ich habe noch nie gesehen, dass jemand das macht. Bevor ich Jess kennengelernt habe, war auf Tour immer eine Person für die Visuals zuständig, eine für das Licht und eine weitere für die Musik. So funktioniert das normalerweise. Doch Jess kann alle drei Aspekte kombinieren.

Wie sah der Workflow aus?

Nadya: Hm, Jess, hatten wir einen Workflow? Jede Performance ist ziemlich chaotisch. Manchmal sind wir zu zweit, manchmal auch zu zwanzigst. Im Bezug auf Pussy Riot würde ich nicht behaupten, dass wir irgendetwas Festgelegtes haben – es ist alles sehr ad hoc. Deswegen bezweifle ich, dass es so etwas wie einen „Workflow“ gibt. Aber Jess ist für die organisatorischen Vibes bei unserer Arbeit zuständig. Das ist beim Touren sehr hilfreich. Bei einmaligen Auftritten können wir unserer Show freien Lauf lassen und alles von Grund auf neu machen. Doch wenn wir jeden Tag performen, ist das schon schwieriger.

Jess: Es ist ein schönes, wenngleich organisiertes Chaos [lacht].

Es klingt aber so, als ob es eine konkrete Verbindung zwischen den Visuals und der Musik gäbe. Stehen die gezeigten Videos bei euren Konzerten in Verbindung zu den Lyrics? Oder sind sie eher abstrakt?

Nadya: Ersteres. Wir machen audiovisuelle Propaganda: Propaganda für unsere tollen progressiven Werte! Unsere Wunschvorstellung: Das Publikum soll nach einer Pussy Riot-Show zum Protest entschlossen sein. Zum Beispiel indem es ein örtliches Regierungsgebäude besetzt! Wenn wir die Leute dazu bringen können, dann haben wir einen guten Job gemacht. Wir bauen auf große und plakative Buchstaben, aber das müssen gar nicht unbedingt die buchstäblichen Songtexte sein. Das können genausogut die Ideen hinter den Texten sein – oder die Fragen, die sich das Publikum während unserer Performance stellt. Es gibt alle möglichen Arten der Interaktion, um das Publikum zur Aktion zu bewegen.

Damit meine ich alles, was dich in eine bestimmte Stimmung bringen kann. Und in vielen Situation ist die Stimmung ziemlich dunkel, weil wir über ernste politische Themen singen – die Brutalität der Polizei oder Klimazerstörung. Manchmal überraschen wir die Leute aber auch gerne – mit einem unvermittelten Video oder Song in Festtagsstimmung. Oder mit einem versöhnlichen Songende. Sie sollen unser Konzert ja auch nicht komplett desillusioniert verlassen – dafür sorgt ja schon die Nachrichtenlektüre. Ich will dem Publikum eine dunkle Stimmung vermitteln, es aber auch mit Hoffnung erfüllen – durch Aktionen und indem wir gemeinsam unsere Einstellung ändern. Mir geht es darum, den Leuten zu zeigen, dass das Zusammengehörigkeitsgefühl uns tatsächlich retten und dabei helfen kann, negative Stimmungen zu überwinden. Genau das soll diese Kombination aus Musik und Video in dir bewirken, wenn du eine Pussy Riot-Performance miterlebst.

Die Mitgliederinnen von Pussy Riot, von rechts nach links: Nadya Tolokonnikova, Bita Balogh, Rachel Fannan, Maria Baez

Jess, du hast in den letzten Jahren hauptsächlich als Sound Engineer gearbeitet. Aber bei deiner Arbeit mit Pussy Riot war das nicht deine einzige Rolle. Wer von euch macht was bei den kommenden Pussy Riot-Performances?

Jess: Meine Rolle erweitert sich stetig – bislang habe ich fast immer die Musik eingespielt und die Performance abgemischt. Bei unserem neuesten Stück war ich für die Lichter und das Video zuständig. Das war mein erster Ausflug in die Welt von Resolume und das VJing. Kurzgesagt: Ich war Managerin der Tour und der Produktion. Zweiteres bedeutet: Ich weiß, was Nadya und das Team machen wollen, und organisiere dann alles, was dafür notwendig ist. Egal ob das ein Festival ist, zu dem sie ohne mich eingeflogen werden, oder ein Konzert, bei dem ich dabei bin. Wenn wir bestimmtes Equipment brauchen, bin ich dafür zuständig. Oder Laptops beschaffen – wie machen wir das auf der Bühne? Müssen die Laptops vernetzt werden? Das ist eine Art Vogelperspektive.

Mit dieser Perspektive sitze ich bei ihren Konzerten auch am FOH-Mischpult und sorge für den Monitorsound. Maria, die Gitarristin und Keyboarderin, lässt das Playback laufen, aber ich mische die Klangquellen zusammen und bereite vor dem Auftritt den Computer vor – alles installieren und konfigurieren.

Außerdem programmiere ich die Beleuchtung in Live und die Videoclips. Ich kann die Rollen schon gar nicht mehr zählen, die ich bei Pussy Riot einnehme...

Dann bekomme ich auch das gesamte Videomaterial und packe das in Resolume, kümmere mich um die Vernetzung und füge das ganze Universum zusammen – damit alles automatisiert, vorhersehbar und hoffentlich narrensicher ist.

Also organisierst du alles hinter den Kulissen und sitzt bei den Shows am Mischpult. Die Gitarristin triggert dann das Live-Playback für die Musik und die Visuals?

Jess: Genau – ich richte alles so ein, dass es möglichst einfach ist. Wir nutzen Setlist – ein Plug-in von Strange Electronics. Und Live ist das Gehirn, das die MIDI-Noten an die wichtigen Stellen schickt – zum Beispiel die DMX-Box oder Resolume, vielleicht auch ein Program-Change-Befehl an Nadyas Subbass-Synth oder andere Dinge.

Pussy Riot-Mitglied Maria Baez beim Proben für einen Auftritt in Los Angeles

Wie und warum habt ihr euch mit den visuellen Aspekten der Live-Performance befasst?

Jess: Das musste einfach gemacht werden. Grundsätzlich will ich jedes Projekt mit dieser Einstellung angehen: „Sag niemals nein. Wenn es einen Weg gibt, das zu machen, und ich ihn kenne, beziehungsweise herausfinden kann: Dann klappt das auch.“

Früher haben Pussy Riot Videoclips in Live abgespielt, und da habe ich mir große Sorgen über die Stabilität der Hardware gemacht. Denn es ist viel Arbeit für einen einzigen Computer, Video und Audio gleichzeitig abzuspielen. Ich habe viel Erfahrung mit der Wiedergabe, habe große Probleme gesehen und behoben – weiß also, wovon ich rede. Als Software-Engineer kenne ich mich mit der Computer-Performance ziemlich gut aus – und der Notwendigkeit, Computer vor Überhitzung und Überlastung zu schützen. Als Pussy Riot auf mich zukamen, sagte ich ihnen: „Das muss auf einen Video-Laptop verlagert werden, der sich überall, wo wir landen, leicht konfigurieren lassen muss.“ Wir waren für einige große Festivals in aller Welt gebucht, deswegen wusste ich: Das Setup muss wirklich einfach sein. Und es gab kein Budget für eine VJ oder LD, also haben wir das einfach so gemacht.

Wie ist die visuelle Ebene der Live-Performance denn gestaltet?

Jess: Mir geht es immer darum, dass alles zuverlässig und möglichst leicht reproduzierbar ist. Wir wussten, dass wir an bestimmten Punkten gezielt Lichter haben wollten – oder wenigstens ein Stroboskop. Die übrige Lichtsteuerung ist ziemlich unkompliziert. Es gibt keine Frontbeleuchtung oder Movers, der Fokus soll auf den Videos liegen. Für Nadya ist das fast der wichtigste Aspekt der Performance. Wir wollten die Betonung auf bestimmte Momente legen, und Nadya schlug vor, dafür Stroboskope zu beschaffen. Damit haben wir dann erstmal losgelegt. Je nach Größe der Bühne hatten wir zwei bis vier davon – weiß, rot oder blau. Mehrfarbig, je nach der Farbtemperatur der Songs. Dann haben wir uns getroffen und das Set an einem Tag geprobt. Nadya sagte mir, an welchen Stellen sie Stroboskop-Einsatz haben will, ich habe es dann so programmiert – das war es dann auch schon.

Es gibt also Lichter und dann noch eine Videoprojektion. Wir hatten eine Leinwand, bei einigen Festivals gab es auch eine LED-Wand. Unser Beamer war mit dem Resolume-Laptop verbunden, und das war die Video-Komponente.

Zusätzliche Show-Elemente waren zum Beispiel ein paar Dekorationen, wie auf diesem Tisch [zeigt auf einen Instrumentenständer] und das klassische Pussy Riot-Absperrband. Außerdem Warnlichter, die sie während der Performance an- und ausschalteten, aber die waren nicht automatisiert.

Und Tänzerinnen. Sie haben immer Tänzerinnen dabei.

Wie ist das Liveset in Ableton Live aufgebaut?

Jess: Bei solchen Anlässen arbeite ich am liebsten in der Arrangement-Ansicht – weil die Band einfach so ist, wie sie ist. Wie Nadya schon sagte: Kontrolliertes Chaos. Nicht selten wollen sie beim Soundcheck noch etwas ändern. Und deswegen nutze ich weniger die variable Session-Ansicht, sondern lieber die Arrangement-Ansicht. Denn darin kann ich auch das Setlist-Plug-in verwenden. Setlist ist einfach super. Wenn sie auf die Idee kommen, die Song-Reihenfolge zu ändern, lässt sich das damit im Handumdrehen machen.

Also: Arrangement-Ansicht. Lokatoren. Und Setlist greift das alles auf. MIDI-Spuren mit Hüllkurven für die Lichter, die sich bei Bedarf ändern lassen. Wenn ein Licht an sein soll, geht die entsprechende Hüllkurve hoch, und wenn die Farben verschoben werden sollen, verschiebe ich einfach deren Hüllkurven.

Das Video wird dann von einer MIDI-Note getriggert, die über RTP-MIDI an den Resolume-Laptop gesendet wird – das passiert immer gleich zu Beginn der Songs. Nicht so wie beim VJing, wo mit verschiedenen Texturen und Überblendungen gespielt wird, sondern eher: „Das ist das Video für diesen Song“. Das Video wird getriggert und geht dann in den Äther.

Dies ist das erste Projekt, bei dem du sowohl den Sound als auch die Visuals steuerst. Gefällt dir diese ganzheitliche Perspektive?

Jess: Klar – das ist fantastisch! Nachdem ich das für Pussy Riot herausgefunden hatte, nutzte ich es auch in meinen eigenen Livestreams. Ich habe die Methode auch schon in Masterclasses unterrichtet und sie Freunden gezeigt, die Livestream-Shows oder Musikvideos machen. Es ist wirklich toll, alles an einem Ort zu haben. Wenn ich das auf die herkömmliche Weise machen würde, müsste ich ein teures Lichtpult kaufen, das Platz beansprucht und erlernt werden will. Natürlich bieten Lichtpulte noch mehr Möglichkeiten für die Performance – damit kann man eine spektakuläre Lichtshow machen.

Wenn ich eine neue Show gestalte, beginne ich zwar schon mit MIDI-Controllern, die auf die verschiedenen Farb-Hüllkurven gemappt sind, die es für die Kommunikation mit den Lichtern braucht. Aber ich habe einfach gerne alles an einem Ort. Meine Software-Nerd-Perspektive sagt mir, dass auf dem Laptop eigentlich nur ein Programm laufen sollte und nicht vier. Dann muss ich mir nämlich über die Stabilität dieser Programme und die Rechenleistung Gedanken machen. Und damit die Bearbeitung komfortabel ist, sende ich keinen Timecode an eine Instanz, die dann möglicherweise aus dem Sync fliegt. Nee nee – lieber alles an einem Ort, und wenn das Video mal nicht passt, dann verschiebe ich einfach die MIDI-Note.

Warum hast du dich dafür entschieden, den zweiten Computer, auf dem Resolume läuft, via MIDI über RTP anzusteuern?

Jess: Zuerst mal funktioniert RTP mit oder ohne Kabel. Ich wollte mit Kabel – drahtlos ist zwar schön, aber ich wollte vermeiden, dass irgendjemand den drahtlosen Router hackt. Der zweite Grund: Ich wollte nicht, dass uns ein lahmes Netzwerk die Show vermasselt. Und RTP-MIDI bevorzuge ich aus Prinzip – es gibt zwar Plug-ins, die das gleiche machen, aber es ist so simpel und ressourcenschonend, eine MIDI-Note abzufeuern. Viel besser, als noch ein weiteres Plug-in geladen zu haben.

Meine Ableton-Wiedergabe-Sessions sind total penibel organisiert. Das liegt daran, dass ich schon mehrmals echte Katastrophen miterlebt habe – die Leute haben mehrere Plug-ins genutzt, ohne zu wissen, wie viel Rechenleistung das beansprucht. Aus diesem Grund verzichte ich meist sogar auf EQs, Auto Filter oder Ähnliches. Bei mir bleibt alles wirklich komplett minimal. Wenn ich etwas bearbeiten und neu rendern kann und Live nur eine Sache macht – nämlich WAV-Dateien und MIDI-Noten abspielen – ist schon viel gewonnen. Schließlich stehen die beiden Laptops auf der Bühne, während ich hinter dem Publikum am FOH-Mischpult sitze. Wenn es dumm läuft, brauche ich mehrere Minuten, um das wieder zum Laufen zu bringen – ein riesiger Stress. Deswegen dachte ich: „Jawoll, lasst uns einfach MIDI-Noten abfeuern und fertig.“

Hast du nach der Entwicklung dieses Systems für Pussy Riot noch andere Tools oder Workflows kennengelernt, die du allen, die sich mit Licht oder Visuals noch nicht so auskennen, empfehlen würdest?

Jess: Ich habe vor allem meine Lichtprogrammierung ausgebaut. Bei mir zu Hause gibt es mehr Lichter, als wir auf die Tour mitnehmen konnten, und ich habe die MIDI-Controller damit verbunden. Mein Tipp: Nutzt auf jeden Fall MIDI-Controller-Mappings. Ich habe einen Akai MPK und einen APC-Controller. Auf dem einen Controller habe ich acht Drehregler, auf dem anderen neun Fader, und damit fahre ich die Show. Ich bekomme ein Gefühl dafür und zeichne bereits auf, während ich mir den Track anhöre. So habe ich das für die Performance von neulich gemacht (siehe oben). Das war neu für mich, aber ich kann es sehr empfehlen – es ist viel greifbarer als an neun verschiedenen Hüllkurven rumzubasteln. Denn das wird sehr schnell alt.

Nach der Programmierung der Pussy Riot-Show habe ich noch etwas anderes entdeckt: Wenn du in der Session-Ansicht von Ableton Live performst und dort Samples und Loops triggerst, kannst du auch kleine MIDI-Clips mit Hüllkurven in die Clip-Slots packen. So triggerst du nicht nur Samples, Loops und One-Shots, sondern gleichzeitig auch die Beleuchtung. Du kannst auch Querverbindungen zwischen den Zuweisungen schaffen. Am Ende geht es einfach nur darum, die richtige Hüllkurve zur DMXIS-Box zu senden, und dafür gibt es viele verschiedene Wege. Bei Licht betrachtet ist das fast wie Sidechaining: Man sendet die Daten von einem Ort an den anderen und dann in die DMXIS-Box. Auf diese Weise können richtig wilde Effekte entstehen.

CLAUDE Synapse

CLAUDE ist ein audiovisueller Künstler aus Seoul, Südkorea. Er entwickelt generative Objekte mit digital-organischer und abstrakter Qualität und Glitch-Sounds, die auf Echtzeit-Informationen basieren. So will er die Grenzen von Audio und Video zwischen sich selbst und dem Publikum neu ausloten. Bei Synapse, eine seiner neuesten audiovisuellen Arbeiten, dreht sich alles um Bilder, die in unserer Erinnerung und auf der Gefühlsebene abstrakt erscheinen, und auf komplexen neuronalen Vorgängen zwischen Organismen und Zellen beruhen.

Wie kamst du auf die Idee, Visuals für deine Musik zu entwickeln – und dafür TouchDesigner zu nutzen?

Ich fand die Live-Performance schon immer spannend. Als ich anfing, elektronische Musik zu machen, suchte ich bereits nach einer passenden Performance-Umgebung dafür. Und schon als Kind war ich künstlerisch unterwegs und fest entschlossen, ein Video für meine Auftritte zu gestalten. Mit der audiovisuellen Performance habe ich mich autodidaktisch auseinandergesetzt – hauptsächlich über Abletons YouTube-Channel und das offizielle Wiki und die Community von TouchDesigner. 2017 besuchte ich das Festival Mutek Tokyo und fand dort heraus, dass viele Künstler:innen TouchDesigner nutzten. Visuals zu entwickeln, die in Echtzeit auf meine Musik reagieren – das fand ich superspannend. Und so fing ich sofort damit an, das Programm zu erkunden.

Worum geht es bei Synapse , und wie wird das von der Musik und den Visuals dargestellt?

Bei Synapse geht es um das Nachdenken über die menschliche Erinnerung, Gefühle und die Grundstrukturen des Lebens. Das Audiosignal von Live wird in Echtzeit auf die Visuals angewendet, um die Formen und Veränderungen der verwendeten Objekte zu erzeugen.

Deine Arbeit enthält generative Objekte, die auf Echtzeit-Daten basieren. Welche Art von Daten sind das, und wie integrierst du diese Techniken in den Sound und die Visuals?

Ich nutze online gefundene Echtzeit-Daten aus der Natur, zum Beispiel in Bezug auf das Klima und die Wasserstände verschiedener Länder. Nachdem ich die Daten in Excel analysiert und arrangiert habe, sende ich die zugewiesenen OSC-Botschaften an TouchDesigner. Oder an Live. Ab diesem Punkt können die Inhalte durch die Daten gesteuert werden – ich wende sie auf die Algorithmen der Klangerzeugung und die Erzeugung der Visuals an.

Ein Still von Synapse: Die Verbindung zwischen den Zellen und dem komplexen menschlichen Nervensystem, interpretiert in Form einer Landschaft

Laufen Ableton Live und die Visuals auf demselben Computer?

Ich nutze zwei Laptops – einen für die live gespielte Musik und den anderen für die live gespielten Visuals. Die beiden Computer kommunizieren via OSC – entweder über WLAN oder ein LAN-Kabel. Für die OSC-Verbindung brauche ich kein eigenes Programm – nur den OSC-Ein- und Ausgang von TouchDesigner und Max for Live.

Ich vermute, dass du die Max-for-Live-Anwendung GrabberSender für die OSC-Kommunikation zwischen TouchDesigner und Ableton Live verwendest. Warum gerade diese Methode?

Ich finde OSC detaillierter und auch komfortabler als MIDI. Mit LiveGrabber lassen sich fast alle Parameter und MIDI-Noten in Live in OSC-Signale umwandeln. Das bedeutet unendlich viele Möglichkeiten für audiovisuelle Arbeiten – ein Format, das meine Kreativität nicht einengt.

Nach deiner Synapse-Performance im Artechouse in Washington hast du darauf hingewiesen, wie wichtig der Ort für deine Performance ist. Warum war zum Beispiel dieser Ort so perfekt? Und wie würde der ideale Raum für die Aufführung aussehen?

Künstler:innen wollen dem Publikum durch ihre Arbeit etwas vermitteln, und der Veranstaltungsort spielt dabei eine sehr wichtige Rolle. Artechouse ist ein immersiver 360°-Raum – ein toller Ort für Synapse, bei dem es um die menschliche Erinnerung und die Strukturen des Lebens geht. Das Publikum soll über die Leinwand und die Sounds in die Performance eintauchen – eine überwältigende Erfahrung. Aber generell gesagt ist der ideale Ort dort, wo unsere Vision am besten zum Tragen kommt – ganz egal ob das ein immersiver und weiträumiger Ort ist oder ein ganz kleiner Raum.

Hast du Tipps für Musiker:innen, die in die Welt der Visuals eintauchen wollen?

Überlege dir zuerst, was du audiovisuell ausdrücken willst. Der Einfluss der Musik auf uns und der Inhalt, der vermittelt werden kann, ist grenzenlos. Doch sobald wir anfangen, die Musik durch Videos zu erweitern, kann der Fokus konkreter sein – ganz direkt oder auch abstrakt. Die wichtigste Überlegung kommt gleich zu Beginn: Welche Teile der Performance werden das Publikum berühren und bewegen?

Text und Interviews: Angelica Tavella